巢状学习(Nested Learning)模仿人脑以多时间尺度协同运作的机制,让模型各元件依不同更新频率学习与整合信息,使神经网络在持续学习中兼具快速反应与稳定记忆

Google研究人员公开了巢状学习(Nested Learning)这项新型模型训练方法,主张将单一模型视为多个彼此衔接或并行的嵌套学习子问题,并以不同更新频率运行,目标是在持续学习中降低灾难性遗忘(Catastrophic Forgetting),同时提升对长文本的理解与记忆管理能力。

所谓的灾难性遗忘,是指模型在持续学习过程中,新数据的训练会将权重向符合新任务的方向调整,从而覆盖掉原先针对旧任务学到的特征表示。

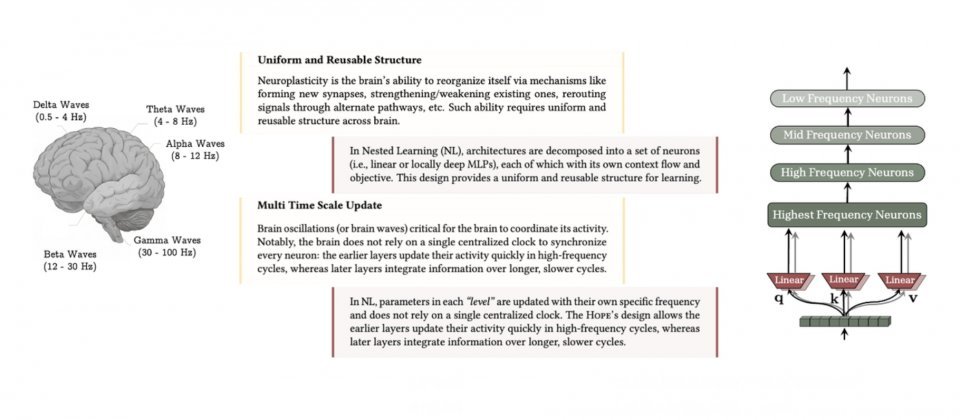

巢状学习的创新点在于重新定义了架构与优化之间的关系。研究将模型拆解为多层级的优化子问题,每一层按更新频率排序,并各自拥有上下文信息流(Context Glow),形成在多时间尺度上协同运作的学习系统。通过这种层级化设计,模型不仅能处理输入窗口中的即时上下文,还能跨多个时间尺度整合新旧知识,其概念更接近人脑神经可塑性巩固记忆的机制。

研究人员从全新视角重新理解模型内部的运作机制,认为像反向传播(Backpropagation)或注意力机制这些深度学习的基本组件,其实都可以被视为记忆过程的一部分。也就是说,模型在学习时,不只是调整权重,更是在构建不同层次的关联与回忆方式。这种对模型的新理解,使研究人员能够用统一的架构来设计和优化模型。

研究还提出了连续体记忆系统(Continuum Memory Systems)的新理念,主张人工智能的记忆不应仅分为短期与长期两种,而应像光谱一样,依据更新速度形成多层次的记忆结构,使模型在吸收新知识的同时,更稳定地保留旧知识,避免遗忘过往能力。

Google开发了Hope实验模型来验证这一理念。Hope能够自主调整记忆方式与学习规则,即让模型学会如何学习。相比以往仅能在固定层级调整的架构,Hope能够在更多层面同时更新与优化,因此在长时间学习或处理大规模内容时,展现出更强的稳定性与记忆扩展能力。

在多项语言建模与常识推理测试中,Hope模型表现优于现有主流架构。Google指出,Hope在语言模型评估中的困惑度更低,表明模型能更精确地预测句子中的下一个词。在常识推理任务上的准确率也更高,显示出其推理能力和知识整合效果更优。

在更具挑战性的长上下文任务中,例如“大海捞针”(Needle-in-a-Haystack)测试,Hope展现出优异的记忆管理能力。官方对比显示,在不同难度等级的长上下文任务中,Hope与Titans均显著优于TTT与Mamba2。