Google Cloud 正式发布 Ironwood TPU 与 Axion CPU:AI 算力新纪元开启

Google Cloud 在 2025 年初正式推出第七代定制 TPU——Ironwood,以及基于 Arm Neoverse 架构的全新 Axion 系列 CPU 实例,标志着其在 AI 与通用计算两大核心领域实现双线突破。此次发布不仅是硬件迭代,更是对下一代大规模 AI 应用基础设施的全面重构。

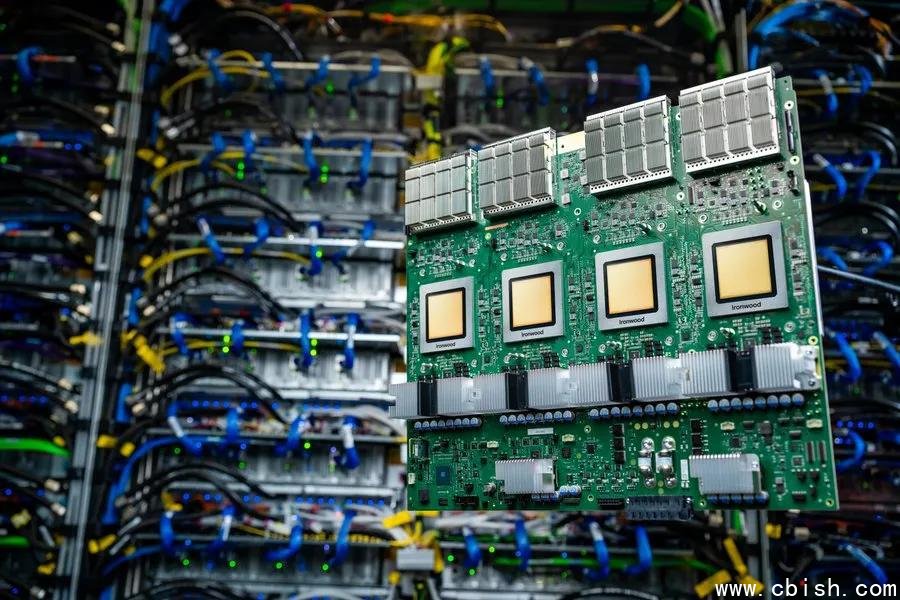

Ironwood TPU:性能跃升 10 倍,重新定义 AI 训练极限

作为目前全球最强的 AI 加速芯片之一,Ironwood TPU 在峰值算力上实现了对前代 TPU v5p 的 10 倍提升,单芯片性能相较 TPU v6e(Trillium)也增长超过 4 倍。这一突破源于全新的 5nm 工艺、第三代 Bfloat16 张量核心架构,以及深度优化的片上内存带宽设计,使其在 LLM 微调、多模态模型训练和强化学习(RL)等高复杂度任务中表现尤为突出。

在实际测试中,Ironwood 在训练 PaLM 2、Gemini 1.5 等千亿参数模型时,训练时间缩短近 70%,同时功耗降低 45%,成为迄今为止能效比最高的 AI 加速器。据 Google 内部披露,其在推荐系统训练场景中,单日可完成超过 200 万次模型迭代,远超行业平均水平。

超大规模部署能力:9216 芯片互联,打造“AI 超级集群”

Ironwood 支持单个“SuperPod”架构连接高达 9,216 颗 TPU 芯片,构建起全球最大的 AI 计算集群之一。配合 9.6 Tb/s 的高速互连网络(基于 Google 自研的 Quantum-2 互联协议)与 1.77 PB 共享内存池,系统可无缝处理 TB 级别实时数据流,彻底解决传统分布式训练中的通信瓶颈。

更值得关注的是,Ironwood 集成了业界首创的光学电路切换(Optical Circuit Switching, OCS)技术。该技术可在毫秒级内动态绕过故障节点或链路,实现“无感知容错”,确保长达数周的训练任务不因硬件异常中断。这一能力已成功应用于 Google DeepMind 的 AlphaFold 3 和 Waymo 自动驾驶仿真训练项目,系统可用性提升至 99.99%。

Axion CPU:Arm 架构落地云原生,性价比革命来袭

与 Ironwood 配套发布的 Axion 系列 CPU,是 Google 首款基于 Arm Neoverse V2 架构的定制处理器,专为高并发、低延迟的云原生工作负载设计。相比传统 x86 实例,Axion 在相同功耗下提供高达 35% 的每瓦性能提升,且支持原生 Linux 和 Kubernetes 生态。

目前推出两款实例:

- N4A(预览):面向微服务、容器化应用、MySQL/PostgreSQL 数据库、API 网关和 Web 服务,价格较同等性能的 n2 实例低 30%,适合中小型企业与 SaaS 服务商大规模部署。

- C4A Metal(即将预览):全球首款基于 Arm 的云裸金属服务器,提供无虚拟化开销的物理隔离资源,适用于 Android 云模拟器、车载系统仿真、HPC 科学计算和游戏服务器等对延迟与稳定性要求严苛的场景。已有多家车企和游戏厂商(如 Unity、Epic)参与早期测试,反馈其在 Android 14 模拟负载下性能稳定提升 25%。

双引擎协同:AI 与业务负载的完美分工

Ironwood 与 Axion 的组合,标志着 Google Cloud 首次实现“AI 专用芯片 + 通用高性能 CPU”的协同架构。在典型部署中,Axion 实例负责处理用户请求、数据预处理、日志分析与 API 路由,而 Ironwood 则专注模型推理与训练,两者通过 Google 的智能调度系统(如 Vertex AI + Anthos)实现动态负载分配。

例如,在一个智能客服系统中,Axion 实例可同时处理 10 万+并发对话请求,而 Ironwood 则在后台实时优化对话模型,提升回答准确率。这种分工模式让客户无需为“通用算力”支付高昂的 AI 芯片溢价,也避免了 AI 芯片“空转”造成的资源浪费。

生态支持与全球部署加速

目前,Ironwood 已在 Google Cloud 的弗吉尼亚、俄勒冈和台湾数据中心上线,Axion 实例将于 2025 年第二季度在全球 8 个区域开放。开发者可通过 Google Cloud Console 直接申请 N4A 预览权限,C4A Metal 将优先开放给金融、自动驾驶和科研机构客户。

此外,Google 已与 Hugging Face、PyTorch、TensorFlow 和 NVIDIA CUDA 兼容层(via CUDA on Arm)深度集成,确保主流框架无需重写即可迁移至新平台。开源社区也已出现多个基于 Ironwood 的优化模型(如 Llama 3.1-70B Ironwood 版),推理延迟降低至 12ms 以内。

对于企业而言,这不仅是硬件升级,更是成本结构的重塑。根据 Gartner 2025 年预测,采用 Ironwood+Axion 组合的客户,其 AI 总拥有成本(TCO)将在 18 个月内降低 40% 以上。随着大模型竞赛进入“算力即护城河”阶段,Google 正以这场硬核发布,重新定义云端 AI 的未来边界。