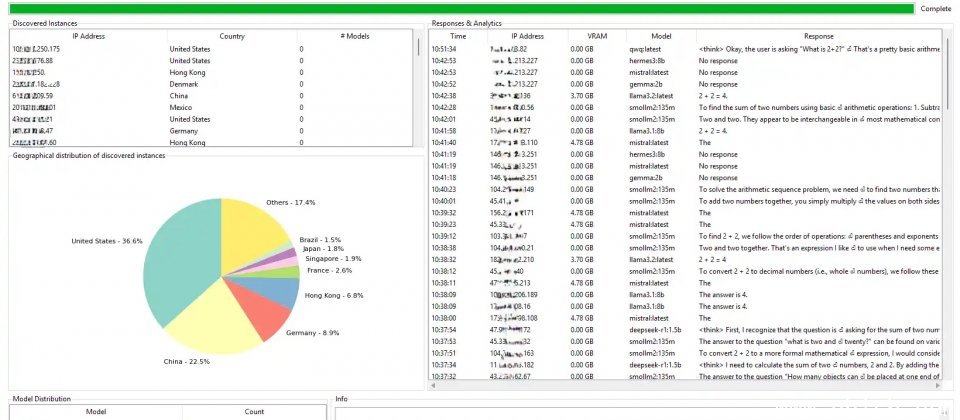

思科通过Shodan搜索引擎配合自制Python工具,检测到1,139台Ollama服务器对外开放,其中214台可在无任何认证的情况下响应请求并执行模型推理,约占18.8%。不少企业和个人在部署大型语言模型(LLM)时忽视访问控制与网络隔离,形成可被滥用的攻击面。

Shodan是一个专门索引互联网上公开连接设备与服务的搜索引擎,能够发现对外开放的端口与服务器横幅信息(Banner Information),经常被研究人员用于盘点外泄系统。Ollama则是一个可以在本地运行大型语言模型的热门开源框架,可方便开发者下载与操作各种模型,并支持OpenAI兼容的API接口,默认运行于11434端口。

研究人员采取被动式检测,以降低触发入侵检测或违反使用政策的风险。第一阶段使用Shodan查询,锁定Ollama常见的11434端口与服务横幅,再结合关键字比对,研究人员发现,许多实例在HTTP头部中显示Server为Uvicorn,这一指标被用于强化指纹识别。第二阶段,研究团队进行极简测试,请求验证服务器是否要求认证,当服务器响应HTTP 200并正确回复测试结果,表示可在未经认证的情况下接受并执行模型推理请求,安全风险极高。

结果显示,这些外泄服务器分布广泛,美国占36.6%,中国占22.5%,德国占8.9%,其中约8成虽未加载模型,但仍能对外接受连接,潜在风险包括被未经授权上传模型、配置修改或进行资源耗尽攻击。另一项值得注意的是,88.89%端点使用OpenAI兼容路径,如v1/chat/completions,而这样的标准化虽有利于应用整合,但也使攻击者能快速横向滥用不同平台。

外泄的大型语言模型服务器可能遭遇多种攻击,包括未经授权的API使用、模型抽取、提示词注入生成不当内容、资源劫持导致成本上升,甚至通过模型上传机制植入后门。对于目前尚未启用模型的服务器,攻击者同样能利用其开放端点进行破坏或滥用。

研究人员建议企业采取分层式防护措施。首先,必须强制启用API密钥或OAuth2认证,并搭配基于角色的访问控制(RBAC)。其次,应将服务器部署于私有子网,并通过VPN或防火墙限制来源。对于API流量,需引入速率限制、异常行为检测与审计日志保存。

同时,也建议调整默认端口并隐藏服务横幅,以降低被识别的风险。针对模型上传功能,应加入签名或哈希验证,避免恶意文件被植入,最后,企业应通过Shodan或自动化工具持续检测与审计暴露端点,确保服务不会意外对外公开。