Meta宣布推出新一代自我监督式学习(Self-supervised Learning,SSL)视觉模型DINOv3,将训练规模扩展至17亿张影像,模型参数达到70亿,在多项电脑视觉基準测试中,尤其是语义分割、单一影像深度估测及影片追蹤等密集预测任务上,表现超越前代与多个现有方案,并正式释出商用授权的程序码与预训练骨干模型,降低开发者在多领域应用上的採用门槛。

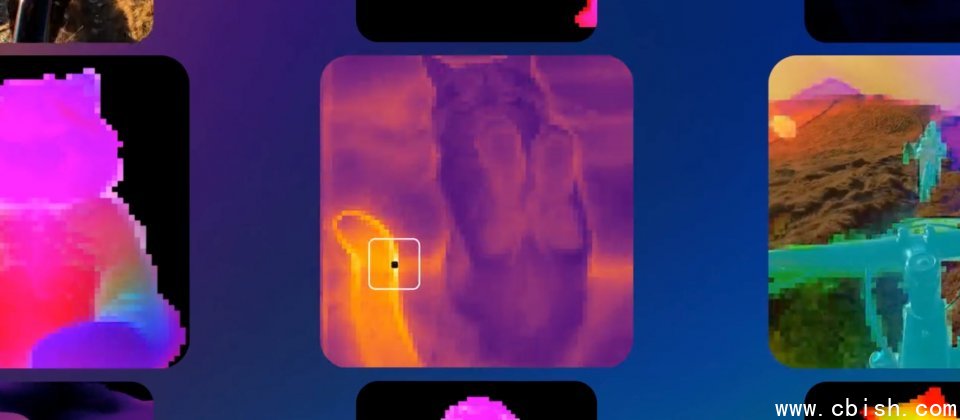

DINOv3延续DINO系列在自监督影像表徵学习的核心理念,不依赖人工标注资料,而是透过大规模未标注影像进行训练,产生高解析度的影像特徵,让后续的下游任务只需极少标注与轻量微调模组(Lightweight Adapter),即可取得良好的结果。

相较于前一代DINOv2,DINOv3的模型规模扩大为7倍,资料集规模增加12倍,并在不进行骨干(Backbone)权重微调的情况下,即能支援多种任务,降低了开发与模型推论的成本,特别适用于边缘运算与同时多任务的部署情境。

在官方公开的评测中,DINOv3在ADE-20K语义分割取得55.9分,优于DINOv2的49.5与SigLIP 2的42.7,而在NYU深度估测中误差下降至0.309,低于DINOv2的0.372与SigLIP 2的0.494。DAVIS影片追蹤达到83.3,大幅领先其他模型。此外,在ImageNet ReaL分类上,DINOv3以90.4分与SigLIP 2持平,ObjectNet分类虽略低于PE(Perception Encoder),但在iNaturalist 2021精细分类则以89.8分领先。

DINOv3的应用範围不限于一般网路影像,也能延伸至卫星、医疗与工业影像等标注困难或成本高昂的领域。Meta同步提供一个以MAXAR卫星影像训练的专用骨干,并在环境监测领域已有落地案例。世界资源研究所(WRI)使用DINOv3进行林冠高度估计,平均误差由4.1公尺降至1.2公尺,有助于自动化验证森林复育成效,加快气候融资拨付流程,并支持大规模的保育与复育计画。

Meta此次释出多种规模的DINOv3骨干,包括适用于资源受限环境的ConvNeXt版本,并附上部分下游评估模型与範例Notebook,方便开发者在不同任务整合使用。Meta提供DINOv3商用授权,研究单位与企业可在合法框架下将DINOv3整合进产品与服务,加速在医疗诊断、环境监控、自主系统及零售等多个产业的应用落地。