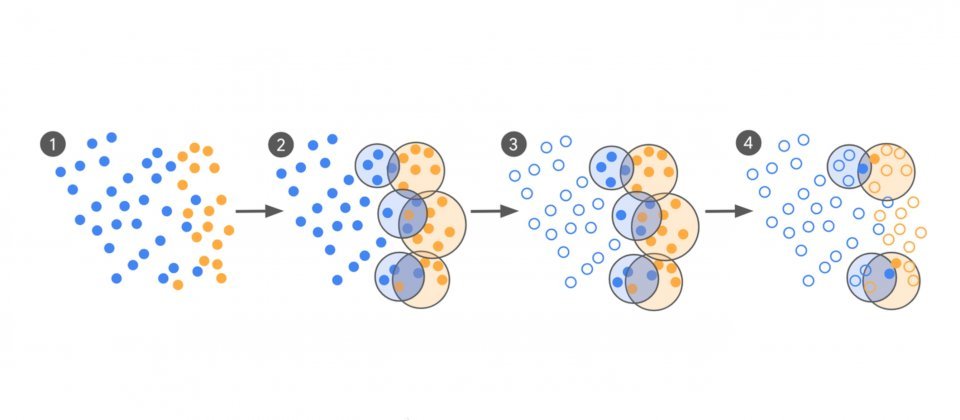

主动式资料筛选与专家标注流程示意,从粗标分类到分群找混淆区,再挑选最具资讯价值样本交由专家标注

Google Ads新发表一套资料筛选与专家标注流程,针对大型语言模型在广告安全领域的应用,能在维持甚至提升模型品质的同时,将微调所需的训练资料量缩减至原本的万分之一。此方法结合主动式学习与专家标注,专注挑选最具判断价值的样本,特别适合处理政策规範变化频繁、正类比例(Positive Rate)极低且需深度语境理解的分类任务,例如侦测点击诱饵或违规广告内容。

整个流程从零或少样本的初始模型LLM-0开始,透过提示对大量广告自动分类为可疑或正常。由于真实流量中正类,也就是违规或不安全内容比例通常不到1%,且初始模型的真正率有限,研究团队会先将正、负类资料分类,再找出两者重叠的交集,这些区域正是模型最容易混淆的判断边界。

系统会从中选取距离最近但标籤不同的样本对,交由两位人类专家进行审核,确保资料同时具备高度资讯价值与多样性。

标注后的资料分为评估资料集与微调资料集,前者用于衡量模型与专家的一致性,后者用于进一步微调模型。评估阶段採用Cohen's Kappa统计量,衡量针对定性项目标注的一致性与评分者间信度,不依赖唯一正确的基準真相标籤,适用于广告安全、诈骗侦测等本质上具争议性的分类任务。整个过程反覆进行,直到模型与专家的一致性接近专家彼此的内部一致性,或进入无法再提升的平台期。

在实验中,Google以两款不同规模的模型,分别是18亿与32.5亿参数在低与高複杂度任务上进行测试,并与使用10万笔群众外包标注资料的传统基準相比。

结果显示,对于32.5亿参数模型,新流程在仅使用250至450笔专家标注资料的情况下,能将模型与专家的一致性提升55%至65%,且在高複杂度任务中也有明显改善。即使资料量减少三至四个数量级,模型的分类品质仍与基準持平甚至更佳。

研究团队指出,要稳定优于群众外包标注,标注品质需达Cohen's Kappa 0.8以上。这项成果显示,结合大型语言模型的大範围涵盖能力与专家在困难样本上的精準判断,可以更有效应对广告安全等快速变动的场景,降低资料蒐集与训练成本,并在政策或内容型态变化时迅速调整模型。