Google发表针对大型语言模型微调过程,导入用户层级差分隐私的最新研究。研究成果在于兼顾模型效能与用户隐私的前提下,解决过去在大型模型训练时执行用户层级差分隐私(Differential Privacy)杂讯过多,导致模型表现受限的问题。

目前开发者在应用大型语言模型时,往往需微调模型提升效能表现,但这些应用大多涉及用户资料,特别是金融、医疗或个人化推荐等对资料敏感度要求较高的场景。传统差分隐私着重于单一样本层级的保护,能降低单笔资料外洩的风险,但Google提到,当单一用户贡献多笔资料时,现有方法难以防止判断用户是否参与训练。用户层级差分隐私则进一步保障用户隐私,让攻击者无法从模型推测特定用户的资料是否被用于训练。

Google团队说明,相较于样本层级差分隐私,用户层级差分隐私在训练过程中须注入更多杂讯,才能确保每位用户的隐私,不过杂讯增加同时会降低模型学习能力,影响整体效能。此挑战在大型语言模型等需要大量运算资源的训练过程中更为明显。过去用户层级差分隐私大多应用于联邦学习(Federated Learning)等分散式训练场景,对于云端资料中心大规模模型训练,现有方法则面临实作与效能的挑战。

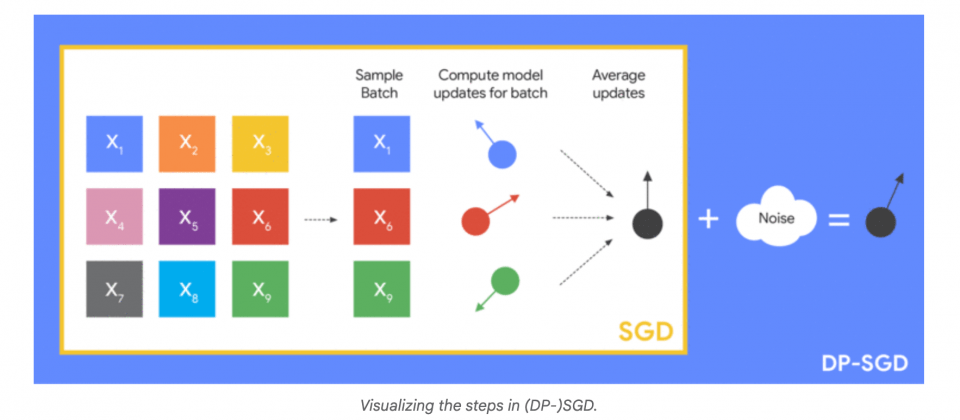

Google提出的新技术重点,在模型微调阶段的用户层级差分隐私最佳化策略,针对差分隐私随机梯度下降训练法进行调整。研究团队比较样本层级随机抽样(Example-Level Sampling,ELS)及用户层级随机抽样(User-Level Sampling,ULS)两种方法。这两种方式均透过前处理限制每位用户的最大样本数,以降低单一用户资料对模型的影响,然后进行后续训练。

Google团队发现过去对于应注入的杂讯量普遍高估,实际所需杂讯可大幅减少,有助于在不影响隐私保障前提增加模型训练成效。此外,研究团队提出用户贡献上限预先设定策略,协助开发者在训练前就选定最佳参数,无需多次试错,进一步降低资源消耗与训练成本。

研究团队在公开的StackOverflow与CC-News资料集上,以3.5亿参数规模的Transformer模型进行测试。实验结果显示,在最佳化的用户层级差分隐私方法,微调后模型效能优于未经微调的预训练模型,而多数情境,ULS模式可取得较佳效能,仅于部分高隐私需求或运算资源有限的情况,ELS模式才具有竞争力。