图片来源:

图片来源: Meta

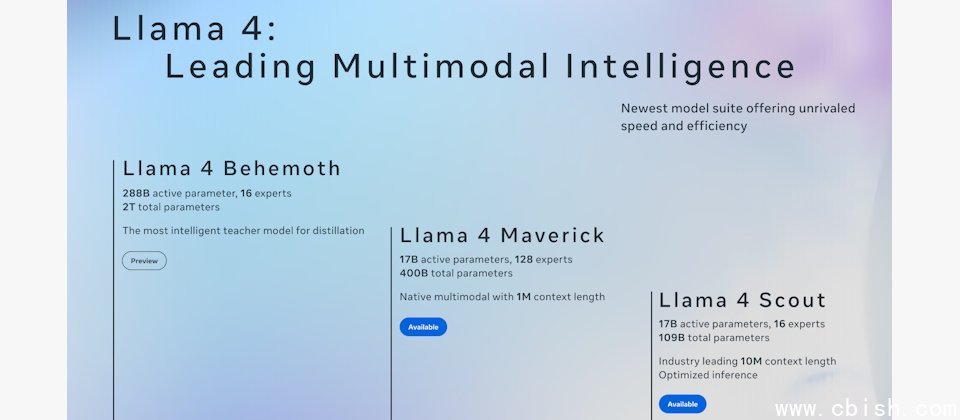

回应新崛起的DeepSeek,Meta上周末公布第一个混合专家(mixture of experts,MoE)模型家族Llama 4,并同时开源4000亿参数的Maverick及1090亿参数的Scout,此外预览高达2兆参数量的Behemoth。

Llama 4是Meta第一个以混合专家(mixture of experts,MoE)架构训练的模型家族。Llama 4训练资料涵盖包含大量文字、图像与影片,涵括200种语言,总字词(token)数为30兆,是Llama 3的两倍以上。

今天开源的二个Llama 4模型,Maverick和Scout都有170亿活跃参数,其中Maverick的MoE层使用128个专家及一个共享专家,总参数4000亿,1M context windows。Scout则有16个专家,总模型参数1090亿,10M context windows。Scout适合单一颗H100 GPU平台。Maverick可快速部署在一台H100 DGX主机上,或採分散式推论架构提升效率。

二个模型现在已在Llama.com及Hugging Face开放下载。Meta未来几天内会提供给合作伙伴。

基于混合专家架构,Llama 4单一字词仅启动一小部份参数,因此在训练和推论更省运算效能,在固定运算资源下能提供比密集模型更好的品质。同时Meta使用了新技术训练。像是运用早期融合(early fusion)手法,可在整合模型骨干上整合大量无标籤的文字和视觉字词。Meta也改良视觉编码器,让视觉编码器更适应LLM。Meta并开发了一个新技术MetaP,使参数可以在不同的batch size、模型规模、训练长度中保持良好迁移性。

藉由MoE架构平行化最佳化配合动态分配GPU资源,提高训练弹性,打破传统分散式架构需要全部模型同时载入的限制,如此一来,相较于前一代架构,训练效率提升约10倍。

后训练部份包含三阶段方法,包括轻量监督微调(lightweight supervised fine-tuning,SFT)、线上强化学习(online reinforcement learning,Online RL)及轻量偏好最佳化(lightweight direct preference optimization,DPO),以提升模型难度的适应能力,同时确保对话语言的品质和智慧平衡。

谈及结果,4000亿参数的Llama 4 Maverick在跨语言、影像与程序码能力表现优异,在多数任务上(尤其是影像、推理、多语言、长上下文)优于GPT-4o、Gemini 2.0。而在程序与逻辑推理能力上,与DeepSeek V3.1(更大模型)互有高下。而1090亿参数的Scout则将支援的context length由Llama 3的128K扩大到10M字词,其标竿测试结果也超越Gemma 3、Gemini 2.0 Flash-Lite和Mistral 3.1。

此外,Meta也公布正在训练中的教师模型Llama 4 Behemoth。整个Llama 4是以FP8精度进行高效率预训练,而Llama 4 Behemoth则是利用Llama 4 Behemoth FP8精度及3.2万GPUs上预训练,达到390 TFLOPs/GPU,它是今天公布最大的MoE架构多模态模型,每字词使用2880亿活跃参数,具16专家模组(Experts),总参数达2兆,是Meta最强、最聪明的模型之一,Llama 4 Maverick正是以Behemoth为教师模型协同蒸馏而成。

Behemoth在理工、科学标竿测试如MATH-500和GPQA Diamond分数,超越GPT-4.5、Claude Sonnet 3.7及Gemini 2.0 Pro。

Llama 4 Maverick及Scout,除了开放给开发人员,消费者现在也可以透过应用程序WhatsApp、Messenger、Instagram Direct或Meta AI网站感受Llama 4。

?