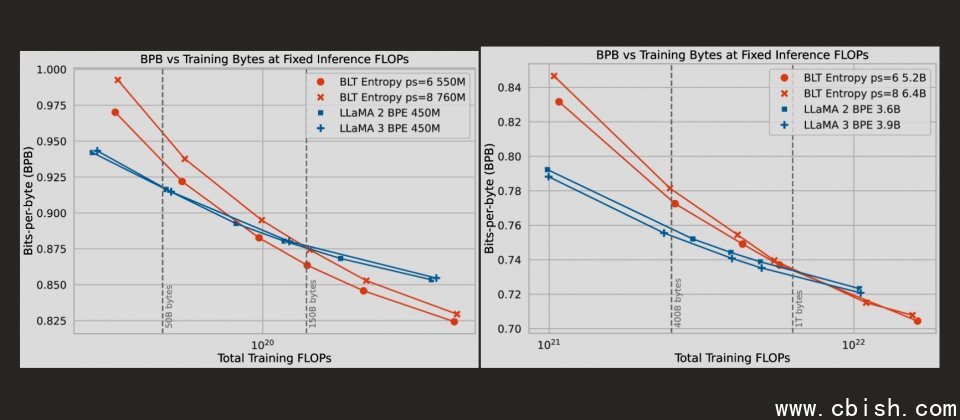

BLT模型在固定推理资源下,透过动态调整补钉(Patch)大小,同时扩展模型规模与效能,展现出比传统分词(Tokenization)模型更好的扩展性。实验显示,补钉大小为6和8的BLT模型,比Llama 2和3更快超越效能限制,特别是在高推理资源下优势更明显。

Meta新推出的BLT(Byte Latent Transformer)架构,重新定义了大型语言模型的运算方式,使得性能以及效率都超越目前主流的分词(Tokenization)模型。该项新技术打破长期以来分词模型在大型语言模型训练中的限制,直接在位元组层级上进行运算,并展现出了在推理效能和模型强健性上的优势。

分词是大型语言模型的技术重点之一,分词模型会将原始字串分解并压缩成固定的字彙单元,以减少处理长序列的运算成本。但是这种方法的限制,随着语言模型的发展日益明显,首先,分词过程中使用的压缩演算法通常带有语言和资料偏差,对非主流语言和多语言环境支援不足。其次是分词模型对输入杂讯的容忍度较低,特别是处理非正规语料时更容易出错。此外,由于分词具静态性,无法根据资料密度灵活分配运算资源,导致资源的分配效率通常与资料的複杂度不一致。

为解决传统分词模型的限制,BLT架构直接从原始位元组资料中学习。这种架构不再仰赖固定的分词单元,而是直接从原始位元组资料中学习,并透过动态分组机制,将位元组根据下一步预测的资料複杂度,分组为大小不一的补钉(Patch),低複杂度资料位元组可被合併成较长的补钉,减少需要处理的补钉数量,高複杂度资料补钉则被分割得更细,让模型能专注于处理资讯密集的部分。

而这些补钉在保持资料完整性的同时,能有效提高模型对资讯密集区域的运算资源分配效率。在实际测试中,BLT展现出比Llama 3等分词模型更高的推理效率,并能在相同的运算资源下同时扩大模型规模与补钉大小。

这种新的设计不仅提高模型的运算效率,也带来了性能上的突破,Meta研究团队表示,BLT模型在处理输入杂讯时,比分词模型更强健,并且在语言学上的细微特徵理解,像是字形结构和拼音规则等方面表现得更好。BLT也能克服低资源语言翻译任务上的劣势,进一步扩展应用场景。

BLT架构由三个核心模组构成,一个是轻量本地编码器,负责将位元组转换为补钉的表示形式,另一个是处理补钉的大型Latent Transformer,第三个模组则是将补钉转回位元组的解码器。这种设计让BLT模型能够根据资料需求灵活调整,大幅降低不必要的运算成本。实验结果显示,BLT的推理效率较传统分词模型提升达50%。