图片来源:

图片来源: Google Cloud

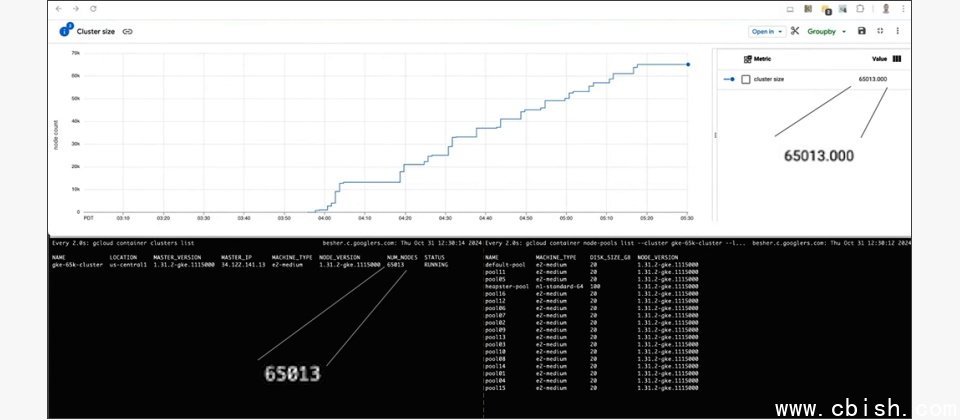

Google Cloud公布最新Google Kubernetes Engine版本,号称可支援最高达65,000个节点的服务器丛集,以执行超大型AI模型。

生成式AI技术演进及应用普及,推升了大型语言模型(LLM)规模及参数量也愈来愈大,目前许多已突破千亿参数,甚至有些来到2兆。而训练这些大型模型的加速器,需要超过1万个节点的运算基础架构。

Google Kubernetes Engine(GKE)向来可支援多节点丛集,以执行AI模型训练任务。先前版本GKE可支援1.5万个丛集节点,随着新版推出,现在GKE可支援高达6.5万个节点的丛集。Google认为最新GKE支援的节点规模,是Amazon和微软的10倍以上。

以Google Cloud而言,现在单一节点提供了多个加速器,像是搭载4颗晶片的Cloud TPU v5e节点,因此单一丛集使用最新版GKE后,最多可管理超过25万颗加速器。

Google说明新版GKE较前代的创新。首先,该公司将Key-Value资料库由etcd换成了以Google Spanner为基础的key-value资料库,后者几乎规模无上限,可改善丛集运作(如启动和更新)延迟性,及无状态丛集控制层(control plane)。Google并实作etcd API以提供回溯相容性,使核心Kubernetes无需变更。

其次,Google改善了管理Kubernetes控制层的GKE基础架构,使GKE现在扩充速度更快,改善的控制层有多重效益,包括能执行高一致性的大容量运算。控制层现在能自动因应运算调节,并使延迟性维持在可预测範围。这点对执行大型动态应用如SaaS、灾难复原和备援、批次部署以及测试环境来说尤其重要。

有了新版GKE,Google Cloud强调更能支援AI模型任务。训练AI模型时企业需要分配运算资源给多个工作负载,因此将任务集中在少量丛集可提供最大调度弹性,执行推论、研究和训练的作业。Google说,由于支援6.5万个节点,现在GKE允许单一丛集执行5种任务,每种任务的执行效能,都足以媲美2023年Google Cloud以5万余颗TPU v5e,缔造的10 exa-FLOPs的LLM训练速度世界纪录。