图片来源:

图片来源: Hugging Face

AI晶片龙头Nvidia与法国AI新创Mistral AI周四(7/18)共同发表了Mistral NeMo 12B,它採用Apache 2.0授权,可直接取代Mistral 7B,开发者可透过Hugging Face存取其基础及指导模型的权重,也已被打包在容器中,可藉由Nvidia NIM的推论服务存取。

Mistral AI是在Nvidia DGX Cloud AI平台上进行训练,利用Nvidia的硬件与软件完成了Mistral NeMo 12B,它支援12.8万个Token的脉络长度,定位为企业等级的AI模型,适用于聊天机器人、多语言任务、撰写程序码及摘录等企业应用。

由于Mistral NeMo 12B在训练时嵌入了量化技术,使得它在执行8位元浮点数(FP8)推论时,不会影响其性能。

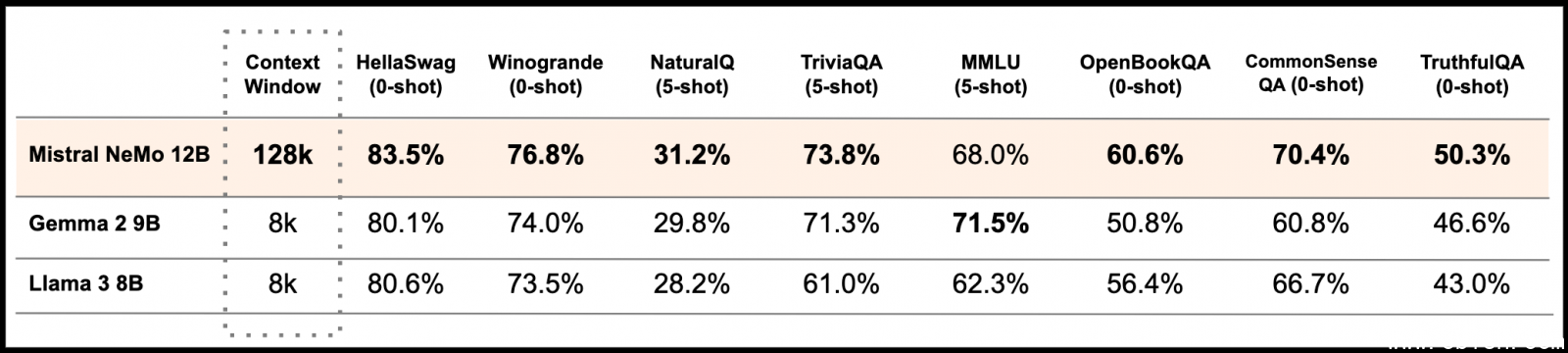

相较于Gemma 2 9B与Llama 3 8B两个开源模型,Mistral NeMo 12B不管是在HellaSwag、Winogrande、NaturalQ、TriviaQA、OpenBookQA、CommonSenseQA或TruthfulQA等基準测试上都明显胜出,只有在MMLU上略逊Gemma 2 9B。

图片来源/Mistral AI

Mistral AI强调,Mistral NeMo 12B是专为全球的多语言应用而设计,而且在中文、英文、法文、德文等十多种语言上特别强大;此外,它也採用了基于Tiktoken的新分词器Tekken,比其Mistral过去模型所使用的SentencePiece,可更有效地压缩自然语言文本及原始码,因此在压缩程序码及中文等语言文本的效率提高了30%,相较于Llama 3的分词器,Tekken更擅长压缩85%的语言文本。

Mistral AI表示,由于Mistral NeMo 12B採用标準架构,因此目前採用Mistral 7B的任何系统都可以直接以它取而代之,并能在几分钟内部署,此外,其授权亦允许企业将它整合至商业应用中。