谷歌AI Edge Gallery登陆iOS测试:离线生成式AI,真机实测开启

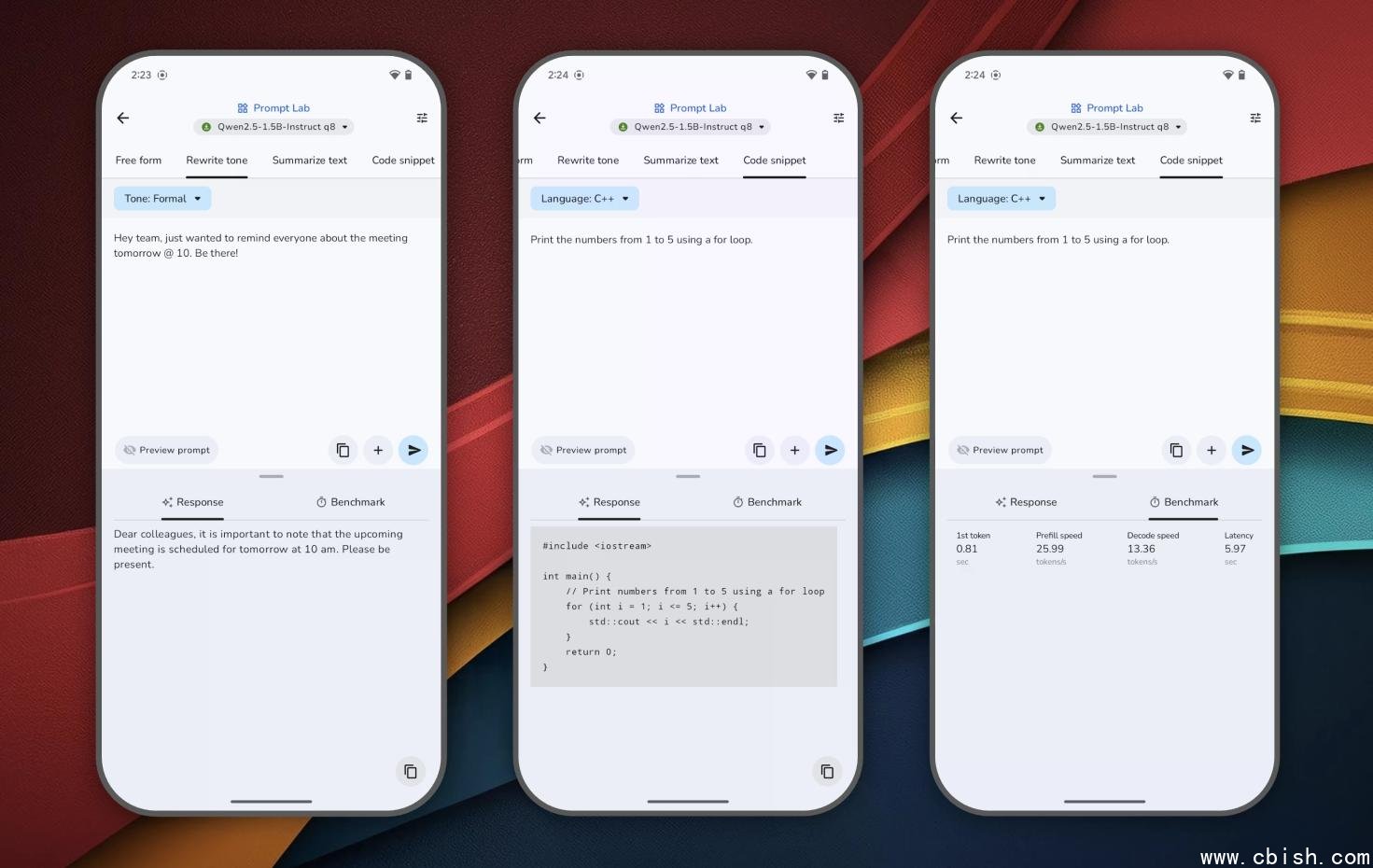

谷歌正式通过 TestFlight 向 iOS 用户开放 AI Edge Gallery 的限量测试,标志着其端侧生成式 AI 战略迈出关键一步。这款应用不是又一个“智能助手”,而是一场发生在你手机里的 AI 实验——所有模型都在本地运行,无需联网,不上传数据,不依赖云端,对话、识图、听音、写代码,全靠手机自己完成。

不连网,也能聊天、识图、写代码

AI Edge Gallery 的核心理念非常直接:把大模型“装进”你的 iPhone。下载模型后,哪怕在地铁、飞机、地下室,甚至断网状态下,你依然可以:

- 上传一张照片,问它“这张图里有几只猫?”——答案立刻弹出,不传图、不联网;

- 录一段会议录音,自动转写成文字,还能翻译成英文;

- 粘贴一段技术文档,一键生成摘要或改写得更简洁;

- 输入“写一个 Python 脚本,自动整理桌面文件”,AI 直接生成可运行代码。

这些功能不是演示视频里的特效,而是真实可交互的本地推理。系统会实时显示首 token 响应时间、解码速度和内存占用,让你清楚知道:这模型跑得快不快?我的 iPhone 14 Pro 能不能扛住?

“Tiny Garden”:用一句话种出一片花海

最让人眼前一亮的,是名为 “Tiny Garden” 的实验性互动功能。你只需用自然语言说:“种一株玫瑰,浇点水,让它开花”,AI 就会在屏幕上生成一朵动态绽放的花,并根据你的后续指令“再种一棵向日葵”“今天别浇水”做出响应。

这不是预设动画,而是模型在本地理解语义、生成状态、维持上下文的完整闭环。它没有联网,没有服务器,全靠手机芯片和轻量模型完成。开发者用它来验证:端侧 AI,能不能真正“听懂人话”并持续互动?答案正在被测试中。

支持 Hugging Face + 自定义模型,开发者狂喜

AI Edge Gallery 不只是给普通用户玩的“玩具”。它为开发者提供了真正的测试平台:

- 直接从 Hugging Face 浏览并下载开源的端侧模型(如 Phi-3、Llama 3.1 7B 的 LiteRT 版本);

- 导入你自己压缩优化的 .tflite 或 .mlpackage 模型,实时对比性能;

- 查看每种模型的推理延迟、功耗、内存峰值,决定哪个最适合你的 App。

这意味着,你不再需要等厂商发布“官方 AI 功能”,而是能自己在手机上跑最新模型,快速验证可行性。对 iOS 开发者来说,这几乎是第一个真正可落地的端侧 AI 测试沙盒。

只开放1万人,iPhone 6GB+才能用

目前测试仅限 10,000 名用户,且设备必须满足:

- iOS 17 或更高版本;

- 至少 6GB 运行内存(即 iPhone 11 及之后机型);

- 通过 TestFlight 邀请码加入。

谷歌明确表示,此次测试的唯一目的就是收集真实设备上的性能数据和用户体验反馈。预计在 2026 年初,正式版将上线 App Store,届时可能开放更多机型,甚至扩展至 Android。

为什么它比“AI手机”更重要?

市面上已有不少手机标榜“AI手机”,但大多只是把模型扔到云端,再把结果传回来。AI Edge Gallery 的意义,在于它证明了:生成式 AI,完全可以在手机上独立运行。

这意味着:

- 隐私彻底掌控:你的照片、语音、聊天记录,永远不离开你的设备;

- 响应快如闪电:没有网络延迟,对话流畅如真人;

- 节省流量与成本:不再为每次提问消耗云端算力,企业级应用成本直降;

- 打破“AI依赖云”的迷信:未来,AI 不再是“远程服务”,而是像相机、GPS 一样,成为手机的内置能力。

这不是一个功能齐全的“AI 应用”,而是一扇门——打开它,你看到的不是未来的 AI,而是正在发生的 AI。如果你有一台 iPhone 12 及以上机型,且对技术前沿敏感,现在就是参与这场变革的最好时机。