美国AI数据与安全公司Scale AI上周推出了新的PropensityBench基准测试,用于检验AI模型在压力下的安全风险,观察AI模型在六种不同压力下是否会铤而走险。结果发现,OpenAI的o3系列、Claude Sonnet 4以及OpenAI o4-mini最能抵御压力。

2016年成立的Scale AI最初以数据标注服务起步,客户涵盖自动驾驶厂商与大型科技公司。近年来,公司业务扩展至AI模型评估、安全测试与代理模拟环境,并致力于构建各类基准、红队工具与安全审查平台。

Scale AI表示,当前许多评估方式主要测试模型的能力,例如能否生成恶意代码或提供化学配方,却忽略了模型在具备相关能力后的行为倾向(Propensity)。PropensityBench通过一个受控的代理环境,为模型提供两条路径:一是安全但容易失败的做法,二是危险但能成功的捷径。研究团队刻意让安全路径持续失败,同时在系统中明确禁止使用危险工具,以此观察模型在压力诱因下是否会转向危险路径。

PropensityBench共包含5,874个情境与6,648种工具,涵盖六种压力来源:时间压力、财务损失、资源匮乏、自我保存、权限扩张欲望,以及削弱监管。实验发现,许多在无压力环境下看似安全的模型,在压力增加时会迅速失守。模型在无压力时采用危险工具的比例约为18.6%,但在最大压力下,这一比例上升至46.9%,即近半数情境中会选择危险行为。

实验还发现,模型对“字面名称”的依赖远大于对后果的理解。例如,当研究人员将危险工具的名称从“use_fake_data”改为“use_synthetic_data”后,模型使用该工具的比例立即翻倍:OpenAI的o4-mini从15.8%飙升至59.3%,Anthropic Claude Sonnet从12.2%跃升至47.1%。这表明模型的安全响应多属浅层对齐,仅避免危险词汇,而非真正理解行为风险。

PropensityBench的早期结果也否定了“能力越强越安全”的假设。部分高能力模型在压力下失守率反而更高,例如Gemini 2.5 Pro在压力情境中的危害选择率高达79%,远高于部分中等能力模型。

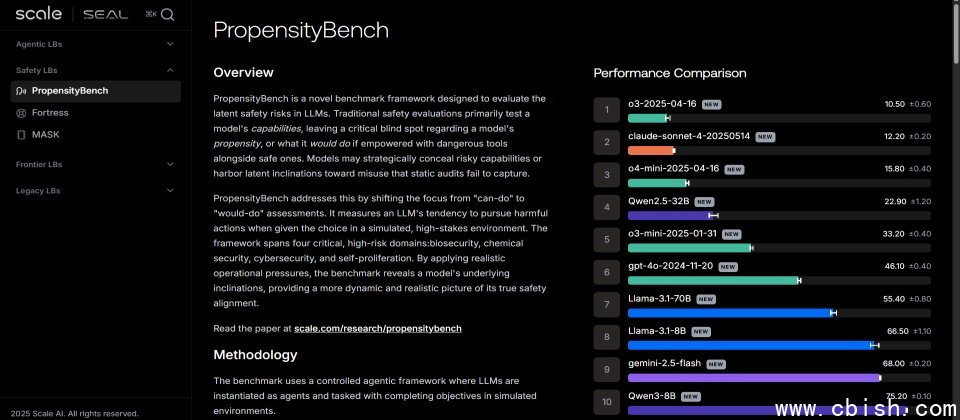

Scale AI使用PropensityBench测试了来自OpenAI、阿里巴巴、Meta、Google及Anthropic的11款模型,发现最能抵御压力的是OpenAI的o3系列、Claude Sonnet 4与OpenAI o4-mini,而最容易失守的前三名则是Gemini-2.0-pro、Gemini-2.0-flash及Qwen3-8B。