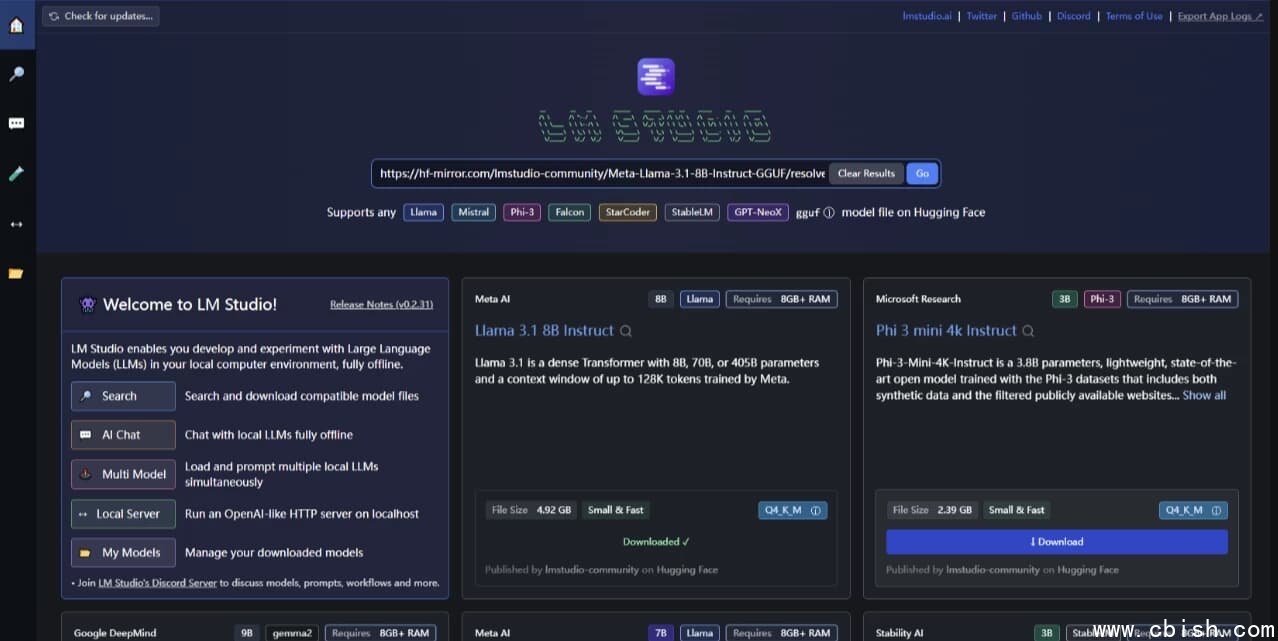

什么是 LM Studio?本地运行大模型的终极桌面工具

LM Studio 是一款专为普通用户和开发者打造的本地大语言模型(LLM)交互平台,无需任何命令行操作,只需下载即用,即可在你的 Windows 或 macOS 电脑上直接运行像 Llama 3、Mistral、Phi-3 这类主流开源模型。它彻底打破了“大模型只能靠云端调用”的传统认知,让你的数据留在本地,隐私不外泄,响应更快速,尤其适合对隐私敏感、网络不稳定或希望离线办公的用户。

无需显卡也能跑大模型?真的可以

很多人以为运行7B以上的模型必须要有RTX 4090这样的高端显卡,但LM Studio基于llama.cpp底层,通过智能量化技术(如Q4_K_M、Q5_K_S等),能在8GB内存的笔记本上流畅运行7B参数模型,16GB内存的设备甚至能运行13B甚至18B级别的模型。它会自动根据你的硬件配置选择最优加载策略,CPU、GPU协同调度,显存不够就用内存补,内存不够就降精度——全程自动,你只需点“加载”。

实测显示,在搭载M2芯片的MacBook Air上,LM Studio可以稳定运行Phi-3-mini(3.8B)并保持每秒15+ tokens的输出速度;在配备RTX 3060的Windows笔记本上,Llama 3-8B也能以接近30 tokens/s的速度运行,完全满足日常问答、写作辅助、代码生成需求。

一键导入Hugging Face模型,支持GGUF格式全家桶

LM Studio内置模型浏览器,可以直接搜索并下载来自Hugging Face、TheBloke等主流平台的GGUF格式模型——这是目前本地部署最主流、最高效的格式。你不需要自己转换、编译、配置,只需在软件里输入模型名称(如“Llama-3-8B-Instruct-GGUF”),点击下载,几分钟后就能直接使用。

支持的热门模型包括:

- Llama 3 系列(8B / 70B)

- Mistral 7B / Mixtral 8x7B

- Phi-3 系列(微软轻量级冠军)

- Qwen 1.5 / Qwen2

- CodeLlama、Zephyr、Dolphin-Mistral 等专业模型

所有模型都经过社区验证,兼容性高,下载后自动缓存,下次启动无需重复下载。

参数调节像玩相机:温度、重复惩罚、上下文长度全可控

你不是在“问AI”,你是在“调教AI”。LM Studio提供直观的滑块和数值输入框,让你轻松控制输出风格:

- 温度(Temperature):值越低越保守(如0.2),适合写报告、编程;值越高越发散(如0.9),适合创意写作、头脑风暴。

- 重复惩罚(Repeat Penalty):防止模型反复说同一句话,比如写故事时避免“他说了又说”。

- 上下文长度(Context Length):支持最高32K tokens,能处理整篇PDF、长篇代码文件或多轮对话记忆。

- 线程数、GPU分层:进阶用户可手动分配CPU线程或指定GPU层处理数量,榨干硬件性能。

这些参数都支持保存为“预设模板”,比如“写作模式”、“编程模式”、“聊天模式”,一键切换,省去反复调整的麻烦。

内置RAG检索增强,让你的本地AI“会查资料”

LM Studio不只是个聊天机器人,它还是你的私人知识库引擎。通过内置的 /v1/embeddings 接口,你可以上传PDF、TXT、Word文档,软件会自动提取语义向量,建立本地向量数据库。当你提问时,它会先从你的文档中检索最相关段落,再结合模型生成答案——这叫“检索增强生成”(RAG)。

实测效果:上传一份公司内部操作手册,问“如何重置VPN密码?”,模型不会瞎猜,而是精准引用你文档中的步骤说明。这对企业员工、研究人员、法律从业者来说,是真正的生产力升级。

无缝对接OpenAI API,现有项目直接迁移

如果你正在开发一个基于OpenAI API的App,但担心费用高、响应慢或数据合规问题,LM Studio能让你“零代码改造”。它内置一个完全兼容OpenAI格式的本地服务器(localhost:1234/v1),你只需把API地址从 api.openai.com 换成 http://localhost:1234/v1,其他代码不用动——ChatGPT的调用方式,立刻变成你本地模型的调用方式。

支持的接口包括:

/v1/chat/completions/v1/embeddings/v1/models

很多开源项目(如LangChain、LlamaIndex、AutoGPT)已原生支持该协议,迁移成本几乎为零。开发者社区已有大量教程教你如何用LM Studio替代OpenAI,节省数百美元/月的API费用。

绿色版免安装,隐私零上传

LM Studio v0.3.25-1 绿色版无需安装,解压即用,不写入注册表,不后台上传数据,不收集用户行为。所有模型、文档、设置均保存在你本地硬盘,连更新都是手动下载,彻底杜绝隐私泄露风险。对于政府机构、医疗、金融等对数据安全要求高的场景,这是目前最安全的本地LLM方案之一。

谁在用 LM Studio?

从大学生写论文、程序员调试代码,到自媒体作者生成文案、律师分析合同、科研人员处理文献,LM Studio正在成为全球数百万用户的本地AI工作站。Reddit、GitHub、知乎上已有大量真实用户分享:用一台旧笔记本跑Llama 3,替代了每月$20的ChatGPT Plus订阅;有人用它搭建了私人AI医生助手,读取医学指南回答健康问题;还有人用它做AI小说生成器,结合RAG上传1000本经典文学,生成风格一致的续作。

你不需要懂技术,也不需要买新电脑。只要有一台能上网的电脑,下载LM Studio,选一个模型,点“加载”,你就能拥有一个完全属于你的、永不收费、永不丢数据的AI大脑。