MiniMax M2.5 上线48小时,已接入50+主流平台

MiniMax M2.5 刚刚发布不到两天,就已经被包括字节跳动、百度智能云、阿里云、腾讯云、讯飞星火、Kimi、通义千问等在内的50多个国内主流产品和平台接入使用。海外方面,新加坡AI初创公司LumenAI、日本对话系统服务商DialogFlow Japan 也已上线测试。不少开发者反馈,M2.5 在长文本理解、多轮对话稳定性上明显优于上一代模型,尤其在客服机器人、智能助手等场景中,响应更自然、出错更少。

M2.5-highspeed:每秒100次响应,快到没感觉

这次推出的 M2.5-highspeed 模型,直接把推理速度拉到了行业新高度——每秒可处理100次请求(100 TPS),是市面上主流模型的3倍以上。有开发者实测,在一个高并发的电商客服系统里,用上这个版本后,用户提问到回复的延迟从1.2秒降到0.3秒,体验几乎“零等待”。不少团队已经把原本需要部署多台服务器的负载,压缩到一台机器就能扛住,成本直接砍掉一半。

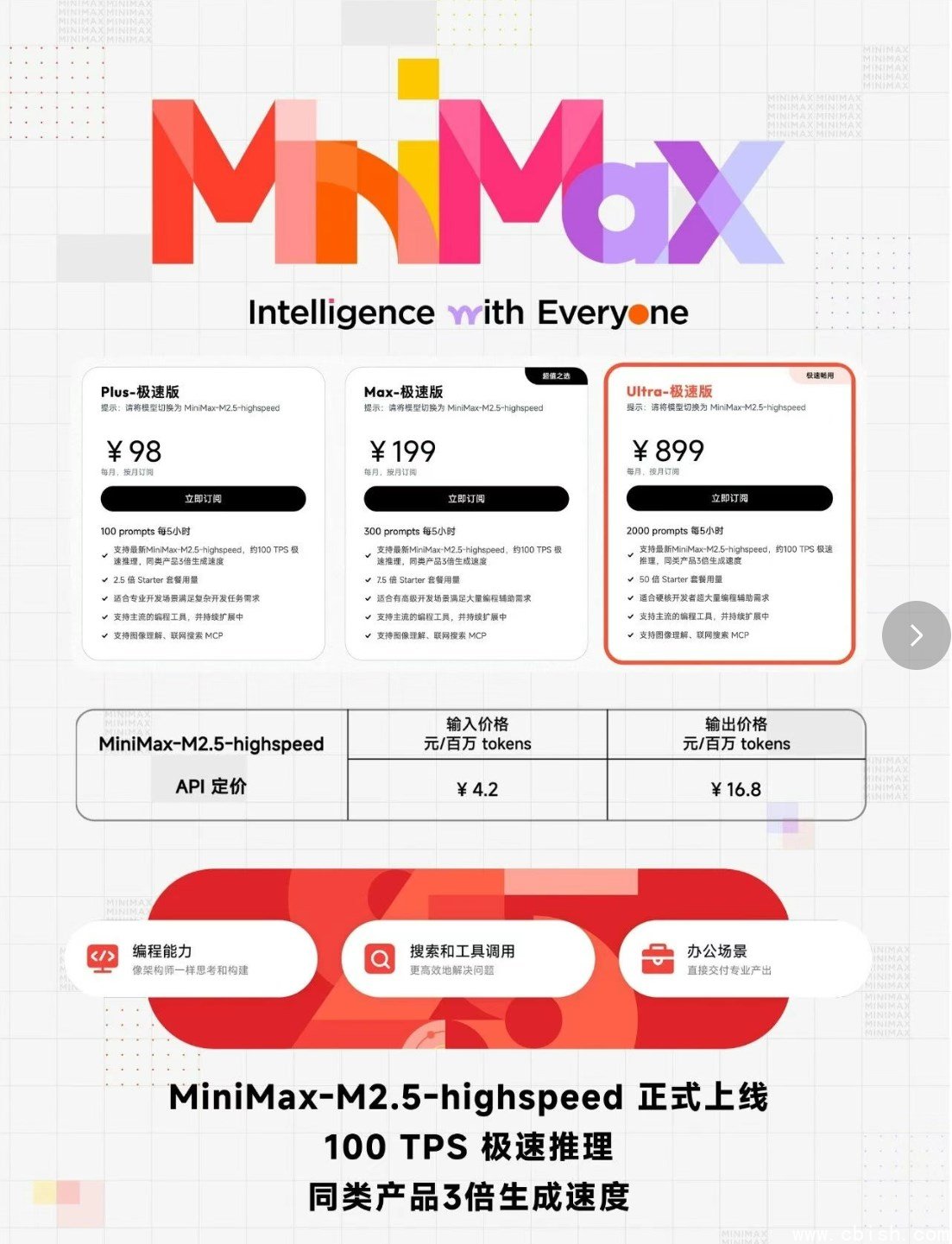

Coding Plan 三档套餐,总有一款适合你

为了让不同规模的团队都能用得上,MiniMax 推出了全新的 Coding Plan,分三种档位:

- Plus:适合个人开发者和小团队,每月50万token,价格亲民,够用不浪费。

- Max:面向中型产品和创业公司,每月200万token,支持API高频调用,性价比突出。

- Ultra:为大型企业定制,支持私有化部署、专属模型微调、7×24小时技术响应。

现在通过好友邀请注册,还能额外享受9折优惠。不少团队已经拉上同事一起拼单,省下的钱够买几台新服务器了。

春节特辑:感谢一路同行

这个春节,MiniMax 团队没放假。他们一边盯着服务器跑得稳不稳,一边回了上千条用户反馈。有位深圳的开发者在论坛留言:“凌晨两点调接口,客服秒回,真没想到还能这样服务。”

我们没想做多炫的技术,只想让用的人觉得“这玩意儿真顺手”。感谢每一位测试、反馈、推荐的朋友。新年愿你写的代码少报错,上线不加班,AI帮得上忙,日子过得踏实。