GLM-5开源即登顶,国产大模型迎来真实突破

2026年开年,国产大模型迎来一次不靠宣传、靠实绩的突破——智谱AI正式开源GLM-5,短短两周内,就在全球权威AI评估平台Artificial Analysis上冲至全球第四,评分与Claude Opus 4.5持平。这不是实验室里的模拟成绩,而是真实开发者在复杂任务中跑出来的结果。

不是参数堆砌,是真能干活

GLM-5的参数规模从3550亿扩大到7440亿,训练数据量达到28.5万亿token,但真正让开发者动心的,不是数字本身,而是它在实际工程场景中的表现。

在SWE-bench Verified测试中,GLM-5以77.8分拿下开源模型第一,比Gemini 1.5 Pro还高。这意味着它能读懂复杂的代码库,准确识别Bug,甚至能独立完成模块重构、修复依赖冲突、优化性能瓶颈。不少一线工程师在社区反馈:“它比我们团队里新来的实习生还靠谱。”

更关键的是,它用了DeepSeek的稀疏注意力机制,长文本处理能力没打折扣,但推理成本砍掉近40%。部署在云上,一台A100就能跑,不需要再为算力焦虑。

开发者能用,才是真开源

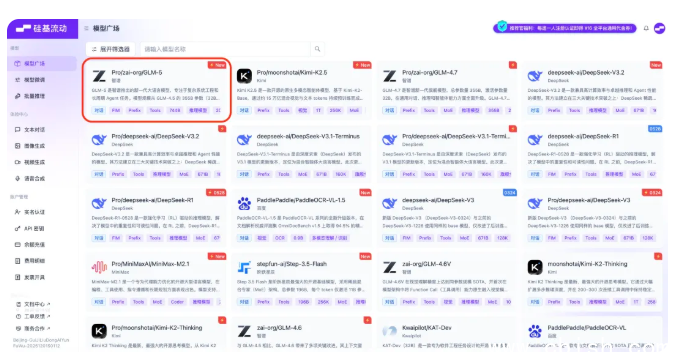

GLM-5不是“发个权重就完事”的开源。硅基流动AI云已上线高速版GLM-5,支持198K上下文,能一口气处理整本技术文档、百万行代码库或完整项目结构。

现在,你直接在Trae、Cline、Kimi Code这些日常用的开发工具里,就能调用GLM-5。写代码时,它不光能补全,还能告诉你:“你这段逻辑在并发下会死锁,建议改用Channel重写。”——不是模板式建议,是真懂工程。

不止GLM-5,国产工具链正在拼图

硅基流动同期还上线了高速版Kimi K2.5,响应速度提升近一倍;PaddleOCR-VL-1.5免费开放调用,识别表格、手写批注、发票信息,再也不用买第三方服务;BizyAir上架了Nano Banana Pro,轻量模型跑在手机端,本地推理无延迟。

这些都不是孤立的更新。它们拼起来,是一个完整的国产AI开发生态:从大模型到OCR,从云端API到本地轻量部署,开发者不再需要东拼西凑国外工具,一套国产方案,能搞定从写代码到识文档的全流程。

真实场景,才是检验标准

有人问:它和GPT-4o比怎么样?

答案不在榜单上,在GitHub上。

已经有团队用GLM-5替换了原有模型,重构了核心服务,上线后故障率下降32%;有创业公司用它+PaddleOCR,自动处理了过去靠人工核对的50万份合同;还有开源项目维护者,靠它自动回复了上千条Issue,效率提升近80%。

技术不需要口号,能省时间、降成本、少出错,就是好工具。GLM-5不是“中国版GPT”,它是中国开发者自己用出来的,能干活的模型。