GLM-5 正式开源:能写代码,更能搭系统

今天,智谱AI正式发布并开源了新一代基座模型 GLM-5。这不是一次简单的升级,而是一次从“辅助工具”到“自主执行者”的跃迁。它不再只是帮你写几行代码、改个前端样式,而是能独立完成从需求分析、架构设计、多模块开发、测试调试,到部署优化的完整工程闭环。

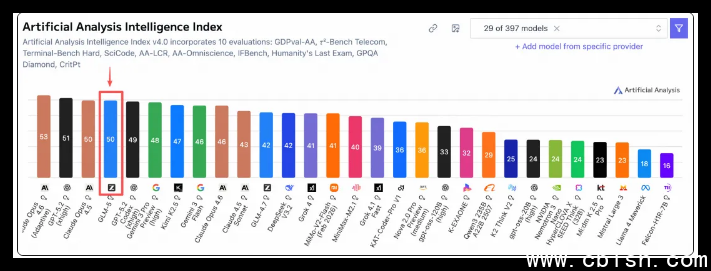

在最新发布的 Artificial Analysis 全球大模型榜单中,GLM-5 排名第四,是目前全球开源模型中表现最强的。它的工程能力,已经接近业界公认的顶尖闭源模型 Claude Opus 4.5,但关键区别在于——它是开源的,任何人都可以下载、部署、定制。

真刀真枪的工程能力,不是纸上谈兵

GLM-5 在真实工程场景中表现惊人:

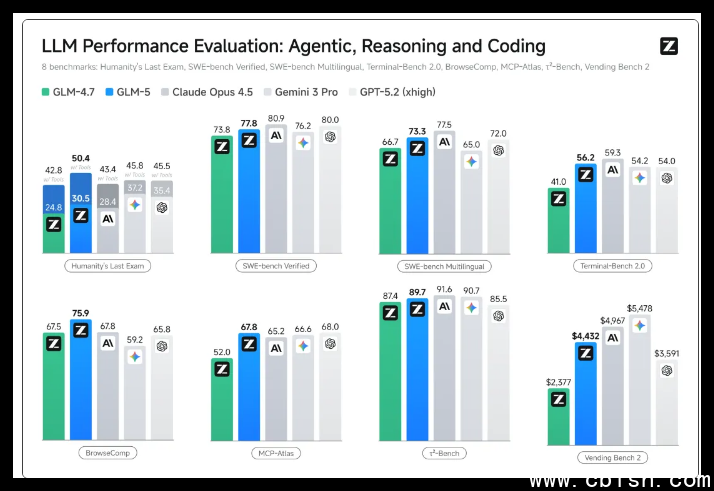

- 在 SWE-bench-Verified(真实 GitHub 仓库修复任务)中得分 77.8,开源第一,超过 Gemini 3 Pro;

- 在 Terminal Bench 2.0(命令行环境复杂操作)中拿下 56.2 分,能独立完成多步骤系统配置、依赖安装、服务启动等任务;

- 在 BrowseComp 和 MCP-Atlas(需要跨网页、调 API、整合信息)中稳居开源榜首,能像人一样“边查边做”;

- 在 Vending Bench 2(模拟自动售货机经营)中,它能根据销量数据动态调整补货策略、定价、库存分配,连续运行 50 天不掉线,利润比人工策略高出 37%。

这些不是模拟题,而是真实世界里工程师每天要面对的问题。GLM-5 不是“写得好”,而是“做得成”。

背后是硬核技术,不是参数堆砌

GLM-5 的突破,不是靠砸更多数据或更大参数堆出来的。

- 模型总参数达 7440 亿,但激活参数控制在 400 亿,兼顾性能与效率;

- 预训练数据量提升到 28.5 万亿 token,覆盖了更多开源项目、技术文档、运维日志和工程论坛;

- 引入名为 “Slime” 的异步强化学习框架,让模型在和用户交互中不断学习、修正策略,就像一个会从失败中总结经验的工程师;

- 集成 DeepSeek 的稀疏注意力机制,在处理 10 万+ token 的长项目文档时,速度提升 40%,显存占用降低近一半,普通消费级显卡也能跑起来。

这意味着,你不需要顶级算力也能用上它。它不是为实验室设计的,是为开发者、团队、中小企业准备的。

国产芯片,原生支持

GLM-5 不只是技术领先,更是一次国产算力生态的协同突破。它已深度适配华为昇腾、摩尔线程、寒武纪、昆仑芯、沐曦、燧原、海光等主流国产芯片平台。

在这些平台上,模型推理延迟低于 200ms,吞吐量稳定在 50+ tokens/s,完全满足企业级生产环境需求。你不需要依赖英伟达,也能在国产服务器集群上稳定运行 GLM-5,这对国内企业来说,意味着安全、可控、成本可控。

不只是模型,是一整套工具链

智谱同步推出了基于 GLM-5 的 Z Code 编程助手,不是插件,是完整的工作流:

- 你给一句需求:“写个能自动抓取京东商品价格并发邮件提醒的脚本”,它会拆解任务、选库、写代码、写测试、跑一遍给你看结果;

- 多个智能体协同:一个负责查文档,一个写代码,一个写单元测试,一个做边界测试,最后合并成完整项目;

- 支持直接输出 .docx、.pdf、.xlsx 文档,比如你给它一份产品需求,它能自动生成带图表的 PRD;

- Excel 插件上线:在表格里输入“分析近三个月销售趋势,画出环比图并标出异常值”,它立刻生成图表和分析报告,无需手动操作。

这不是“AI 写代码”,这是“AI 做工程”。

现在就能用,完全免费

GLM-5 的完整模型权重,已在 Hugging Face 和 ModelScope 开源,采用 MIT 协议——你可以商用、修改、部署,不用交钱、不用申请、不用签协议。

你可以在本地跑,也可以部署在公司服务器;你可以把它嵌入自己的产品,也可以改造它去解决你独有的业务问题。没有黑盒,没有锁死,没有后门。

下载地址:

- Hugging Face: https://huggingface.co/THUDM/GLM-5

- ModelScope: https://modelscope.cn/models/ZhipuAI/GLM-5

这是一次真正的开源行动。不是宣传,是交付。如果你是开发者、技术负责人、初创团队,或者只是想看看 AI 到底能帮你干点啥,现在,就是动手的时候。