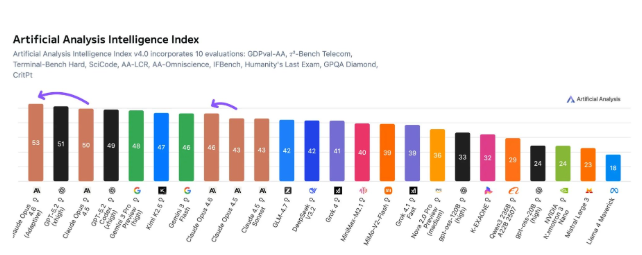

Claude Opus 4.6登顶智能指数,但胜利之下暗流涌动

就在上周,AI领域最权威的评估机构Artificial Analysis发布了最新一期智能指数,Anthropic的Claude Opus 4.6以压倒性优势拿下榜首。这不是一次小幅度领先,而是在编程、代理任务、科学推理等十项硬核测试中全面封王——尤其在处理复杂终端指令、多步骤自动化任务和物理建模课题上,它甚至让此前长期领先的GPT-5.2都显得吃力。

这张成绩单背后,是一组令人意外的数据:Opus 4.6单次推理消耗了约5800万个输出Token,是上一代4.5的两倍,但对比GPT-5.2那高达1.3亿的Token消耗,它用不到一半的“说话量”完成了同等甚至更复杂的任务。换句话说,它更“省嘴”,也更“会说重点”。这在实际应用中意味着更低的延迟、更快的响应,以及对开发者和企业来说更可控的成本。

当然,代价也不小。单次调用成本高达2486美元,比GPT-5.2的2304美元略高,但考虑到它的任务完成质量与效率,不少企业用户认为这笔钱“花得值”。目前,Opus 4.6已全面上线Claude.ai,同时接入Google Vertex AI、AWS Bedrock和Azure AI等主流平台,开发者只需几行代码就能调用——无需排队,无需特殊权限,直接开干。

OpenAI的“秘密武器”正在逼近

但别急着庆祝。就在Opus 4.6登顶的同时,OpenAI内部的Codex 5.3已悄然完成内部测试,正等待最终基准验证。据多位知情工程师透露,Codex 5.3在代码生成、调试优化和工程架构设计上的准确率,比当前任何公开模型都高出15%以上。它不是在“模仿”编程,而是在“理解”系统。

一位在硅谷从事AI基础设施的开发者告诉我:“我试过Opus 4.6写一个分布式任务调度器,跑得不错。但Codex 5.3不仅写出来了,还主动建议我改用Kubernetes的CronJob而不是Celery,理由是资源调度更稳定——这已经不是工具,是搭档。”

更关键的是,OpenAI正在测试一种“动态上下文压缩”技术,能让模型在不损失精度的前提下,将Token消耗降低40%以上。如果这项技术落地,GPT-5.2的“高成本”短板将被彻底逆转。

谁在真正使用这些模型?

有意思的是,真正推动这场竞赛的,不是科技巨头的营销,而是那些在深夜调试代码、写科研论文、搭建自动化流程的普通工程师和研究员。Reddit上一个名为“AI Tools That Actually Work”的板块里,用户们正在比较Opus 4.6和GPT-5.2在真实场景中的表现:

- “用Opus 4.6处理NASA公开的火星探测器遥测数据,3分钟内生成了可视化分析报告,连注释都带了误差分析。”

- “GPT-5.2能写Python,但Opus 4.6能写‘能被CI/CD流水线接受的Python’。”

- “我让两个模型帮我重构一个十年的老项目。Opus 4.6重构了结构,GPT-5.2重构了我。”

这场竞赛,早已不是“谁更聪明”的游戏。它变成了:谁能在你最疲惫的时候,替你扛住最枯燥的活,还不让你多花一分钱。

Anthropic赢了这一局,但OpenAI的底牌还没亮完。而真正决定胜负的,不是排行榜上的数字,而是下一个凌晨三点,你打开终端时,哪个模型能秒回你一句:“试试这个,我改好了。”