灵波科技开源LingBot-Depth:让机器人“看得更清”,不再被玻璃和镜子难住

1月27日,蚂蚁集团旗下具身智能公司灵波科技正式开源高精度空间感知模型 LingBot-Depth。这不是又一次技术演示,而是一次真正能改变机器人视觉能力的底层突破——它让普通消费级深度相机,也能在玻璃、镜面、不锈钢等“视觉禁区”中,输出清晰、完整、边缘锐利的三维深度图。

过去,机器人面对透明或反光物体时,经常“失明”。无论是家里的玻璃茶几、厨房的不锈钢水槽,还是工厂里的镜面机械臂,传统深度相机(包括不少高端品牌)都会在这些表面“看不清”“漏数据”,导致机器人撞上去、绕不开、抓不准。这不是算法问题,而是硬件受限于光学原理——红外光打到镜面上直接反射跑偏,打到玻璃上穿过去,根本收不回有效信号。

LingBot-Depth 的出现,打破了这个困局。

不换硬件,只换“大脑”:让Gemini330相机性能翻倍

这款模型不是凭空生成的。它基于奥比中光 Gemini330系列双目3D相机 的原始芯片数据训练而来——这意味着,你不需要买新设备,只要把现有Gemini330相机的固件升级,接入LingBot-Depth,就能立刻获得远超以往的感知能力。

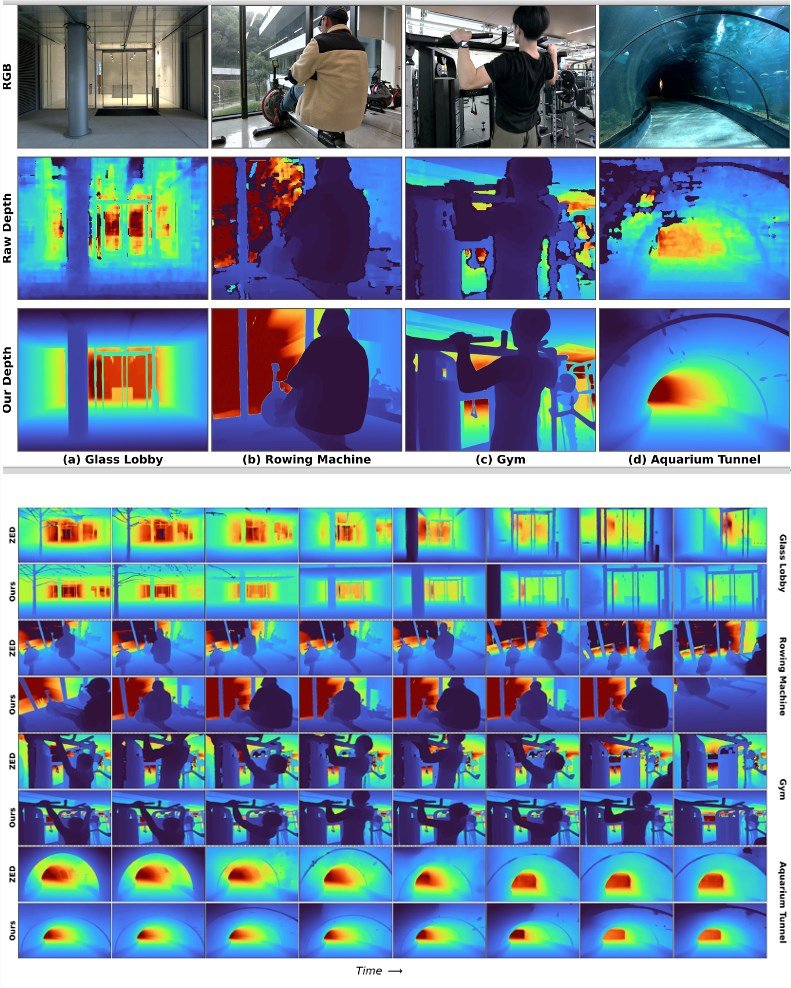

在真实场景测试中,搭载该模型的Gemini330,在面对强逆光下的玻璃门、布满水渍的镜面、曲面不锈钢水箱时,输出的深度图不仅没有大片黑块,连玻璃边缘的细微裂纹、镜面反射的轮廓都清晰可辨。对比业内公认的标杆产品——Stereolabs的ZED相机,LingBot-Depth在这些极端场景下的表现,几乎是降维打击。

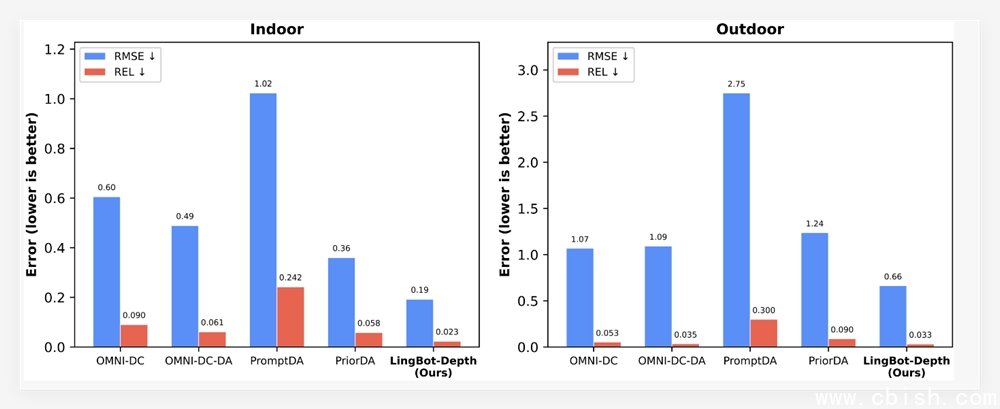

(图说:在最具挑战的稀疏深度补全任务中,LingBot-Depth性能整体优于现有多种主流模型。图中数值越低代表性能越好。)

“掩码深度建模”:用彩色图补足深度盲区

它的核心技术叫“掩码深度建模”(Masked Depth Modeling,MDM)。简单说,就是当深度传感器“看不见”时,模型会“看”彩色图像(RGB)——从纹理、阴影、轮廓、环境结构中,智能推测出缺失的深度信息。

比如,你拍一张玻璃杯的彩色照片,人眼能立刻判断它的形状和位置,哪怕它透明得像空气。LingBot-Depth 做的就是这件事:它不是靠“猜”,而是通过上千万次真实场景的学习,掌握了“什么样的纹理对应什么样的深度结构”。它知道镜面反射的光斑不是噪声,而是物体边缘的延伸;它知道玻璃边缘的模糊轮廓,其实是折射造成的视觉错觉,而不是真的没东西。

这项技术让模型在NYUv2、ETH3D等权威评测中,表现远超主流方案:室内场景相对误差(REL)降低超70%,稀疏SfM任务中RMSE误差下降47%——这意味着,机器人在复杂环境中定位、避障、抓取的准确率,直接跃升一个量级。

1000万组真实数据,不是实验室里的“漂亮数字”

很多人质疑:AI模型是不是只在实验室数据集上表现好?LingBot-Depth 的底气,来自实实在在的数据积累。

灵波科技团队历时两年,在全国20多个城市采集了约1000万组真实环境下的RGB-Depth原始数据,涵盖家庭、医院、工厂、商场、物流仓库等10余类高难度场景。从中筛选出200万组高质量配对数据用于训练,还额外加入了100万组高保真仿真数据,确保模型在极端光照、动态干扰、多材质混杂等真实混乱环境中依然稳定。

这些数据,即将随模型一起开源。这不是“小打小闹”的数据集,而是目前全球公开最大、最贴近真实应用的消费级深度视觉训练数据之一。开发者可以拿它训练自己的机器人、AR眼镜、智能安防设备,甚至用于无人机避障或残障辅助设备。

(图说:[上图]搭载 LingBot-Depth 后,奥比中光 Gemini330系列在透明及反光场景下深度图的完整性和边缘清晰度明显提升,[下图]其效果优于业界领先的ZED 深度相机)

不只是开源,一场行业变革正在启动

灵波科技已与奥比中光达成深度合作,后者计划在2025年第二季度推出搭载LingBot-Depth的新一代深度相机产品,面向消费级机器人、服务机器人、智能家电等市场。这意味着,未来你家的扫地机器人、陪护机器人、自动送餐车,可能不需要换硬件,就能“看得更清楚”。

本周,灵波科技还将陆续开源其他多款具身智能模型,覆盖语义分割、动态物体跟踪、空间导航等方向。这不仅是技术开放,更是一次对行业生态的重新定义——让中小企业、高校实验室、个人开发者,也能用上原本只有大厂才负担得起的高精度空间感知能力。

如果说过去三年是机器人“能动”的时代,那么2025年,将是机器人“看得懂”的元年。LingBot-Depth,不是终点,而是一个开始。