NeurIPS 2025 暴露学术诚信危机:51篇论文藏“幽灵引用”

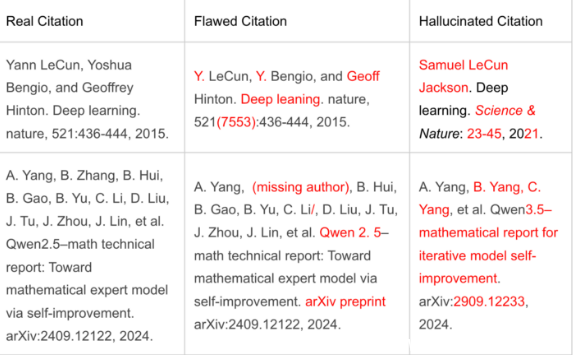

2025年神经信息处理系统大会(NeurIPS)刚公布录用名单,一场隐秘的学术风暴便悄然浮现。AI检测公司GPTZero对全部4,841篇被录用论文展开深度分析,发现其中51篇论文中存在至少100处“虚假引用”——这些引用并非笔误,而是由AI生成、完全虚构的文献条目,伪造了作者姓名、期刊名称、DOI编号,甚至伪造了arXiv预印本链接。

这些“幽灵引用”并非随机错误,而是高度模仿真实学术格式的“伪原创引用”(Vibe Citing)。例如,一篇来自纽约大学的论文引用了“John Doe, 2023, arXiv:2305.XXXX”,而该arXiv编号根本不存在;另一篇谷歌研究团队的论文则引用了一本名为《Journal of Synthetic Intelligence》的期刊,该期刊在任何学术数据库中均无记录。更令人震惊的是,部分伪造的DOI指向了真实存在的网站,但页面内容却是空的,或被重定向至无关的商业广告页。

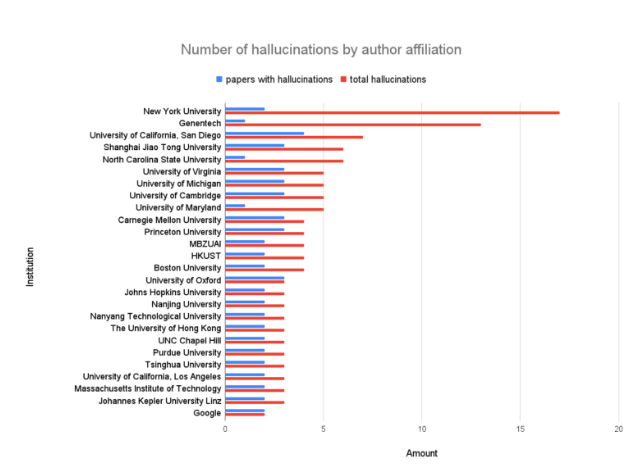

这些造假行为并非来自边缘学者,而是集中出现在全球顶尖机构的研究成果中。纽约大学、斯坦福大学、卡内基梅隆大学、谷歌大脑、Meta AI 等机构均有论文中招。这说明问题已从“技术滥用”演变为“系统性失守”。

为何如此精密的伪造能逃过同行评审?答案在于规模失控。2020年,NeurIPS收到约9,500份投稿;到了2025年,这一数字飙升至21,575份——五年内增长超过127%。为了应对投稿潮,会议组织方不得不大量招募研究生、博士后甚至企业工程师担任审稿人。许多审稿人没有足够时间细读论文,只能依赖AI工具快速生成审稿意见。有内部人士透露,部分审稿人甚至直接将论文粘贴进ChatGPT,用“请总结这篇论文的贡献和不足”来完成评审任务。

更严峻的是,这种“AI代审”模式正在反向催生造假。一些作者发现,只要引用格式“看起来像真的”,AI审稿系统就可能忽略核查。于是,他们开始主动利用AI批量生成看似权威的参考文献,以提升论文“学术厚度”。这种行为被业内称为“引用美容”——不是为了支持论点,而是为了制造学术可信度的幻觉。

目前,NeurIPS官方已紧急更新投稿指南,明确将“虚假引用”列为严重学术不端行为,一经查实将直接拒稿或撤稿,并通报作者所属机构。但专家警告,这仅仅是开始。去年,IEEE和ACM也陆续发现类似案例,部分期刊甚至出现同一组伪造文献被多篇论文重复引用的现象——这意味着,一个由AI生成的“学术幽灵库”可能正在暗中蔓延。

这场危机的深层问题,远不止于几个伪造的DOI。它暴露的是学术评价体系在AI浪潮下的脆弱性:当效率压倒严谨,当机器替代判断,当“看起来专业”取代“真正可靠”,我们还能相信论文里的每一个引用吗?

对于研究者而言,这不是旁观者的故事。如果你曾引用过一篇新论文,而它的参考文献让你觉得“太顺了”“太整齐了”“像模板生成的”——也许,你正在被一个AI编织的幻觉所误导。