GLM-4.7-Flash 开源:30B 模型的新标杆,本地部署也能跑出大模型的体验

今天凌晨,智谱AI正式开源了 GLM-4.7-Flash —— 一个在300亿参数规模下,却只激活30亿参数的“轻量猛兽”。它不是又一个参数堆砌的演示品,而是一个真正能跑在普通服务器、甚至消费级显卡上的实用模型。在代码能力、数学推理和工具调用上,它已经悄悄超越了当前主流的 Qwen3-30B 和 GPT-OSS-20B,成为开发者口中“最像大模型的中小模型”。

不是“小模型”,是“聪明的精简版”

GLM-4.7-Flash 使用的是 MoE(混合专家)架构,总参数300亿,但每次推理只激活其中约30亿。这就像一支精锐特种部队——人不多,但每个都顶得上三个普通士兵。结果就是:你用一张A100或4090,就能跑出过去需要多卡才能支撑的推理速度。

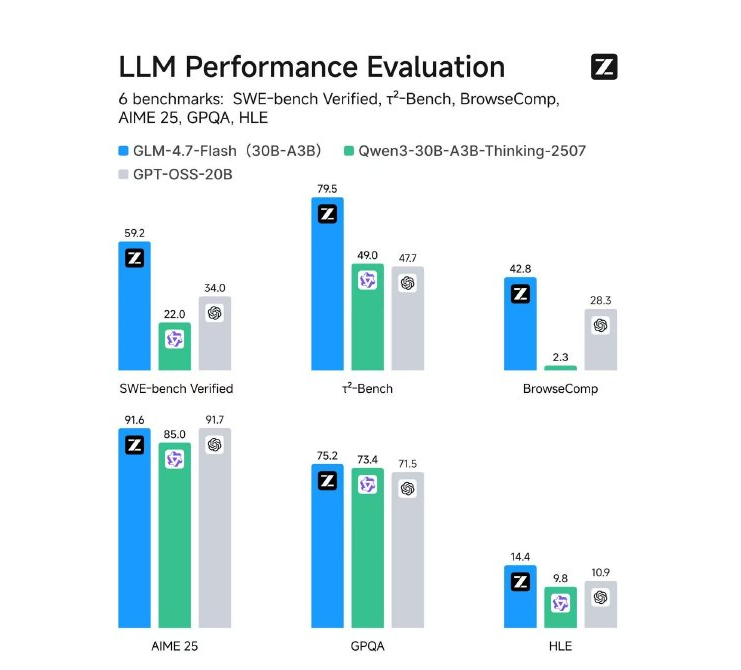

实测数据摆在面前:

- 代码能力:SWE-bench Verified 得分 59.2,比 Qwen3-30B 高出近8分,能准确修复复杂项目中的真实 bug,不是“看起来像能写代码”,而是真能帮你改代码。

- 数学与推理:AIME25(美国数学邀请赛级别)得分 91.6,GPQA(专家级问答)75.2,面对专业级问题,它不再靠“猜”,而是有逻辑地拆解。

- 工具调用:τ?-Bench 79.5,BrowseComp 42.8,在需要调用搜索、API、计算器的复杂任务中,表现远超同级模型,真正能当“AI助手”用。

这些不是实验室里的“美化数据”。不少开发者已经在自己的项目里实测:用它跑本地代码助手,响应快、准确率高,再也不用担心“它说的代码跑不起来”。

开箱即用,不用折腾

最让开发者感动的,不是性能有多强,而是它有多好用。

你不需要自己编译、调参、改配置。Hugging Face 上直接就能下载,一行代码就能加载:

```python from transformers import AutoTokenizer, AutoModelForCausalLM model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.7-Flash", device_map="auto") tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.7-Flash") ```如果你用的是 vLLM 或 SGLang 这类高性能推理框架,支持也已合并进主分支。vLLM 用户可以直接开启 tensor parallel 和 speculative decoding,让吞吐量翻倍;SGLang 用户还能用 EAGLE 算法,把响应速度再压低20%以上。

有人在 Reddit 上说:“我之前用 Qwen3-30B,跑起来卡得像PPT,换上 GLM-4.7-Flash,同样的机器,响应快了一倍,还省了30%显存。”

为什么它能火?因为它解决了真实痛点

过去两年,大模型越做越大,但真正落地的,往往是那些能跑在本地、不依赖云服务、不烧钱的模型。GLM-4.7-Flash 正是瞄准了这个缺口。

它不追求“全球第一”的榜单排名,而是专注一件事:让你的本地AI助手变得真正好用。

你可以在家里用它:

- 写 Python 脚本自动处理Excel报表

- 调试你公司内部的遗留系统代码

- 让AI帮你查资料、总结会议纪要,不上传数据到云端

一位在创业公司做产品原型的开发者说:“我们没预算买GPT-4 API,但又不想用免费版的AI工具。这个模型一跑起来,我直接把整个客服问答系统换掉了——准确率更高,还免费。”

现在就能用

模型已开源,无需申请,无需审核,直接下载使用:

https://huggingface.co/zai-org/GLM-4.7-Flash

如果你正在寻找一个能跑在本地、不卡顿、不依赖网络、还能写代码、能推理、能调工具的模型——GLM-4.7-Flash,可能是你今年见过最务实的开源选择。