AI 不再只会“回答”,它开始“做事”了

过去几年,我们习惯把AI当成一个聪明的问答助手——问天气、查资料、写邮件,它都能应付。但真正的生活场景,从来不只是“问”和“答”。你希望它能帮你关掉客厅的灯、在会议前10分钟提醒你准备材料、自动把微信里的聊天记录整理成待办清单,甚至在你睡着时悄悄把手机调成静音模式。

这些,都不是靠“对话”能完成的。它们需要AI能理解意图、调用系统接口、执行操作,并把结果自然地反馈给你——也就是从“对话工具”变成“执行代理”。而这一次,谷歌没有推出更大的模型,而是做了一件更务实的事:让AI在你的手机上,真正“动起来”。

FunctionGemma:专为本地执行而生的“小脑”

FunctionGemma,不是另一个能写诗、能辩论的AI,它是谷歌基于Gemma 3 270M参数模型专门打磨的“动作引擎”。它的唯一目标:把你说的“帮我定个明早7点的闹钟”,准确翻译成系统能执行的指令,不靠云端,不传数据,就在你手机里完成。

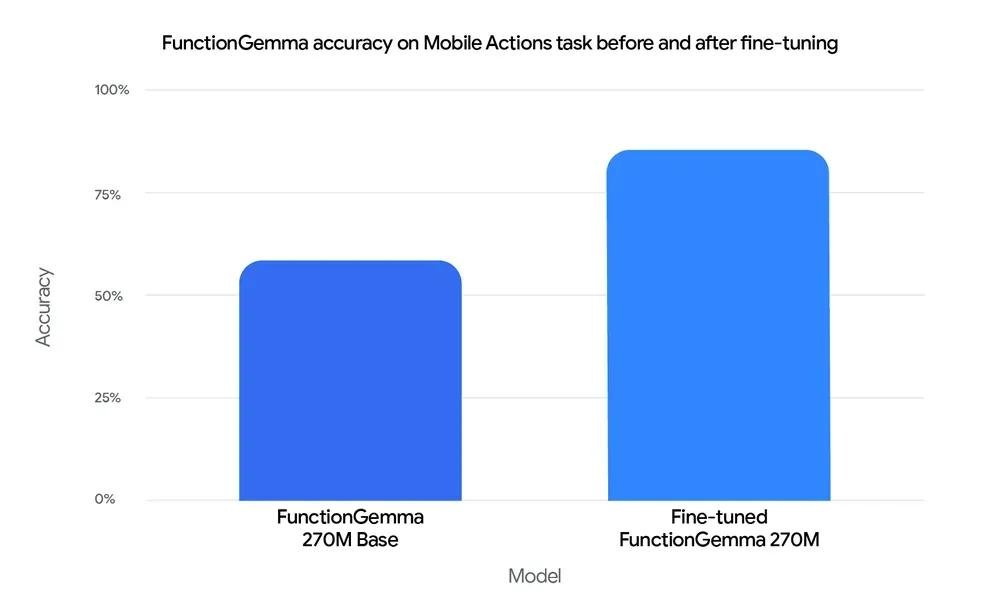

它不是“全能型选手”,而是“专精型选手”。你不需要它懂量子物理,但你希望它能可靠地调用日历、短信、通知、蓝牙、USB设备——哪怕你没连网。它做到了:在谷歌内部的“Mobile Actions”测试中,经过微调后,它准确执行本地指令的正确率从58%跃升到85%。这意味着,它不再“猜你想要什么”,而是“知道你要做什么”。

为什么它能跑在你的旧手机上?

FunctionGemma只有270M参数,比很多手机自带的语音助手还小。但它能高效处理JSON、XML、多语言命令,得益于Gemma家族的256K超大词表——这意味着它能“读懂”你随手写的“把微信里张三发的文件存到下载文件夹”,而不是非要你用标准语法说“调用文件管理器的saveAs接口,路径为/storage/emulated/0/Download/”。

它不依赖云端,所有运算都在本地完成。你的行程、通话记录、聊天内容,从不出设备。这不仅是隐私问题——更是速度问题。当你对手机说“明天早上8点叫醒我,顺便发条消息给妈妈说我到家了”,响应时间不到300毫秒。你甚至感觉不到AI在“思考”,它就像系统自带的一个贴心管家。

它不是孤军奋战,而是“智能协作者”

FunctionGemma不是要取代Gemma 3 27B这样的大模型,而是和它形成“分工协作”:日常简单任务,交给本地小模型快速处理;遇到复杂问题,比如“帮我分析这周的消费趋势并生成报告”,它会自动把任务转给云端大模型,再把结果整合回来。

你完全感觉不到这个切换过程。就像你用导航:最近的加油站,它直接告诉你;但你要规划跨省自驾路线,它才联网查地图、油价、路况。这种“本地优先、云端辅助”的架构,才是真正实用的AI体验。

从开发到部署,全链路开放

谷歌没有把FunctionGemma藏在实验室里。它已经开源,支持主流AI生态:你可以用Hugging Face直接下载模型,用Keras微调它适配你的智能家居设备,用NVIDIA NeMo训练它识别你的语音习惯。

部署更简单:Ollama、LM Studio、vLLM、LiteRT-LM,这些你可能已经在用的本地AI工具,都已支持FunctionGemma。你甚至可以在树莓派、Jetson Nano、甚至旧款iPhone上跑起来。开发者社区里,有人用它做智能家居中枢,有人把它嵌入车载系统,还有人用它自动整理手机相册——识别“宝宝第一次走路”照片,自动归档到“成长记录”文件夹。

这不是AI的进化,是AI的“落地”

过去,AI的竞赛是参数、算力、多模态。现在,真正的战场变了:它能不能在你没开WiFi的时候,依然听懂你的话?能不能在你锁屏时,悄悄帮你关闭耗电应用?能不能在你开车时,用一句话帮你拨通孩子班主任的电话?

FunctionGemma的答案是:能。

它不炫技,不吹嘘,不追求“最强大”,但它做到了一件事:让AI真正成为你口袋里、手里、家里,那个“用得上、信得过、不打扰”的助手。这不是未来,这是2025年已经能用上的现实。

当AI不再需要你“问清楚”,而是能“猜准你下一步”,它才真正从工具,变成了伙伴。而FunctionGemma,正是这个转折点的钥匙。