Mistral AI 推出 Devstral 2 系列:开源代码大模型新标杆

Mistral AI 正式发布新一代开源代码模型 Devstral 2 系列,包含 1230 亿参数的 Devstral 2 与 240 亿参数的 Devstral Small 2,全面面向开发者、企业工程团队与 AI 原生工具构建者。此次发布不仅刷新了开源代码模型的性能边界,更以极低部署门槛和开放许可,重新定义了“谁可以拥有强大的代码AI”。

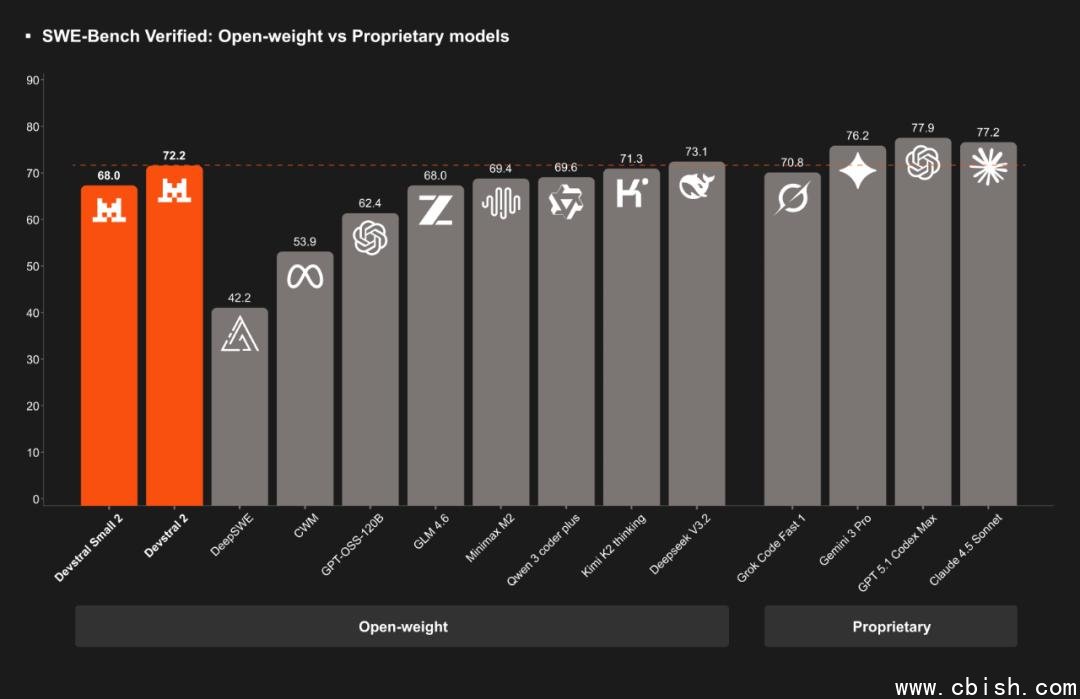

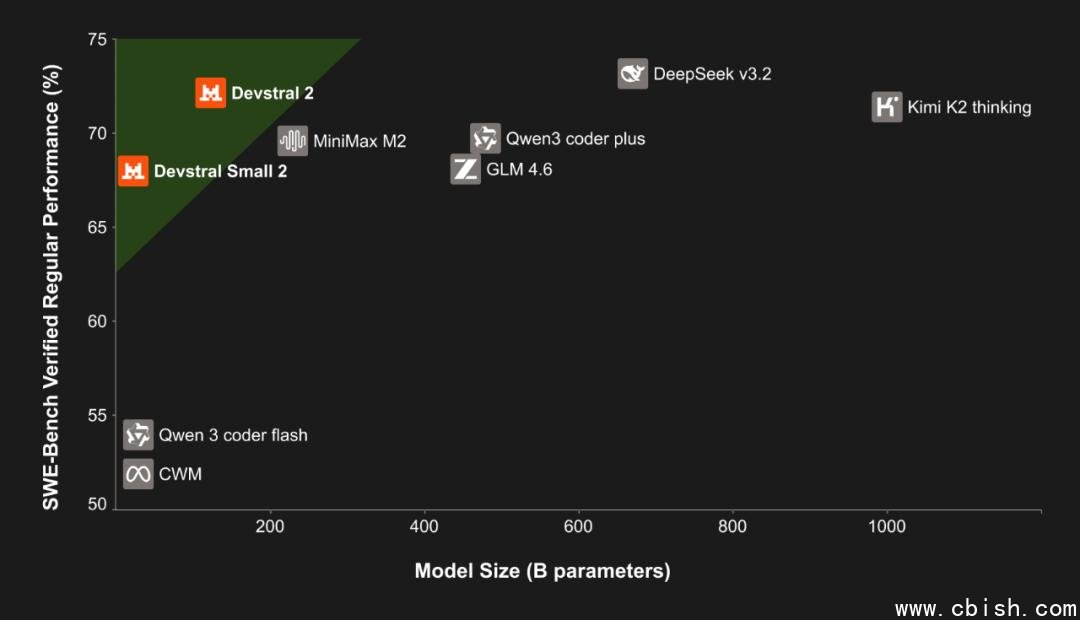

性能碾压:SWE-bench 72.2%,成本效率高达7倍

在权威代码理解与修复基准 SWE-bench Verified 中,Devstral 2 以 72.2% 的通过率稳居开源模型榜首,超越此前领先的 CodeLlama-70B 和 DeepSeek-Coder 等主流模型,甚至逼近部分闭源商业模型(如 GPT-4o 和 Claude 3.5 Sonnet)的表现。更重要的是,其推理成本仅为同类闭源模型的 1/7——这意味着企业用一台 H100 集群就能跑出过去需要数台 A100 才能实现的自动化代码能力。

这一优势源于模型在训练数据上的深度优化:Devstral 2 在超过 20TB 的真实开源代码(GitHub、GitLab、Codeforces 等)基础上,融合了大量调试日志、PR 评论、CI/CD 失败记录与开发者交互数据,使其不仅能“写代码”,更能“理解上下文、诊断错误、预测修复路径”。

256K 上下文:真正处理大型项目

不同于多数模型仅能处理单文件或小模块,Devstral 2 拥有 256K 的超长上下文窗口,可一次性加载整个 Git 仓库(含 500+ 文件)进行分析。这意味着它可以:

- 自动识别跨文件的依赖冲突

- 根据项目历史提交记录推测重构意图

- 在多个文件间同步修改(如更新接口后自动修正所有调用点)

- 执行端到端任务:从“修复登录页登录失败”到生成测试用例、提交 PR、触发 CI,全程无需人工干预

已有开发者在 GitHub 上分享测试案例:Devstral 2 在处理一个包含 87 个文件的 Python Web 项目时,成功定位并修复了因依赖版本冲突导致的异步数据库连接泄漏问题,而此前人工排查耗时超过 6 小时。

Devstral Small 2:消费级设备也能跑的“代码大脑”

如果你没有 H100 集群,也不用担心。Devstral Small 2 仅需 240 亿参数,却在 HumanEval、MBPP 等基准上保持 85%+ 的性能保留率,支持在 RTX 4090、甚至 Mac Studio M2 Pro 上本地运行。更惊人的是,它首次在轻量模型中实现了图像输入能力——你可以截图一张报错界面、一张架构图,或一张手绘的流程图,直接让模型理解并生成对应代码。

这使得它成为独立开发者、学生、远程办公团队的理想选择:无需云服务,无需 API 调用,本地部署即用。有用户已在 Obsidian、Cursor 和 VS Code 中集成该模型,实现“写注释 → 自动生成代码”、“画流程图 → 生成 TypeScript 实现”的闭环体验。

开放许可,真正自由使用

与许多“伪开源”模型不同,Devstral 2 采用修改版 MIT 许可证,允许商用、修改、分发,甚至用于训练下一代模型;Devstral Small 2 则采用更宽松的 Apache 2.0,企业可直接集成进 SaaS 产品,无需支付任何授权费或披露源码。

这意味着:你可以用 Devstral 2 构建自己的 AI 编程助手、代码审查机器人、自动化测试引擎,甚至将其作为商业产品的核心引擎——无需担心法律风险或成本暴雷。

Mistral Vibe CLI:让 AI 成为你的开发搭档

除了模型本身,Mistral AI 还同步发布了 Mistral Vibe CLI——一个原生命令行工具,专为开发者工作流打造。它支持:

- 自动感知当前项目结构(git root、package.json、requirements.txt)

- 跨文件编辑:一次指令修改多个文件(如“给所有用户服务添加 JWT 鉴权”)

- 与 Git 深度集成:自动生成提交信息、创建分支、提 PR

- 支持插件扩展:可接入 Jira、GitHub Actions、Docker Compose 等工具链

示例命令:vibe fix "登录接口返回 401,但 token 有效" → 模型自动检查 auth middleware、token 解析逻辑、数据库查询语句,并生成修复补丁,等待你确认后一键提交。

目前 Vibe CLI 已在 npm 和 Homebrew 上架,安装仅需一行命令:npm install -g mistral-vibe。

行业实测:Cline、Kilo Code 等平台已接入

多家 AI 原生开发平台已率先接入 Devstral 2:

- Cline:将 Devstral 2 作为默认代码引擎,工具调用成功率提升至 91%,用户平均任务完成时间缩短 68%。

- Kilo Code:在内部测试中,Devstral 2 在重构遗留 Java 项目时,比 Claude 3.5 多完成 17% 的自动迁移任务,且错误率更低。

- Replit AI:正评估将其作为免费用户默认模型,以降低运营成本。

“我们不再需要为每个用户分配 GPT-4 的 API 额度,Devstral 2 让我们能为所有开发者提供顶级体验,成本却只有以前的 1/5。” —— Kilo Code 工程负责人

部署建议:选对模型,事半功倍

根据你的使用场景,建议如下:

| 使用场景 | 推荐模型 | 硬件要求 |

|---|---|---|

| 企业级自动化、CI/CD、多文件重构 | Devstral 2 (1230B) | 4×H100 / 8×A100 |

| 独立开发者、本地编程助手、轻量插件 | Devstral Small 2 (240B) | RTX 4090 / M2 Pro / 32GB RAM CPU |

| 教育、研究、原型验证 | Devstral Small 2(量化版) | 16GB RAM,可运行 GGUF 4-bit |

目前,Hugging Face 和 ModelScope 已上线模型权重,支持 GGUF、AWQ、GPTQ 等多种量化格式,方便低资源设备部署。

结语:开源代码AI,正式进入“可用时代”

Devstral 2 不是又一个“参数竞赛”的产物,而是一次对“谁该拥有代码智能”的回答。它让中小团队不再依赖昂贵的闭源 API,让个人开发者拥有企业级工具,让 AI 不再是锦上添花的辅助,而是真正能扛起工程责任的协作伙伴。

现在,你只需一个命令,就能让 AI 帮你修 bug、写测试、重构架构——不是“可能”,而是“已经发生”。