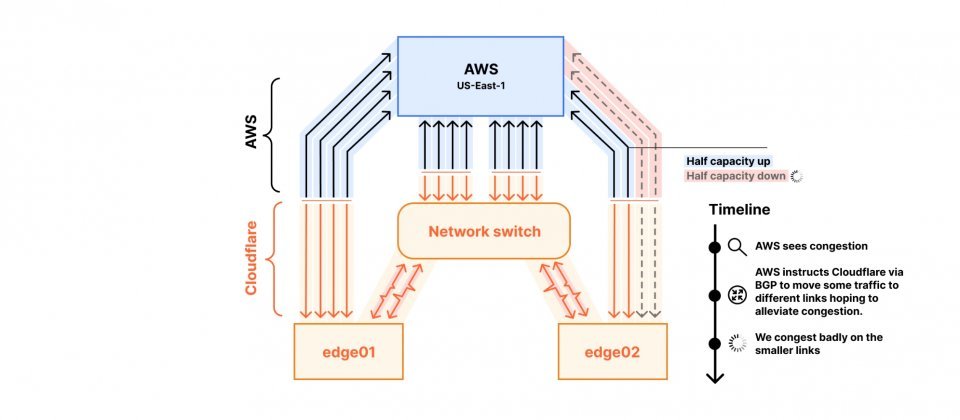

Cloudflare与AWS us-east-1区域间的互连(Interconnect)示意,因单一路径仅剩半数容量运作,AWS在侦测壅塞后透过BGP将部分流量导向其他连线,但次要连线很快也因承载不足而拥塞

台湾时间8月22日00:27,因单一用户自AWS美东云端区域(us-east-1)大量请求Cloudflare快取物件,导致回应流量暴增,使Cloudflare与AWS us-east-1之间的私人网路互连(Private Network Interconnect,PNI)饱和,受影响的使用者出现高延迟、封包遗失与连线到来源服务器失败。事故在03:38已明显缓解,并于04:18完全解除。

此次问题仅限Cloudflare与AWS us-east-1之间的互连路径,非攻击或BGP劫持,全球其他服务均维持正常。

Cloudflare解释,虽然这些请求大多可以直接由快取回应,但回应的流量仍需透过资料中心互连(DCI)和边界路由器传送到AWS,最终导致所有既有的私人网路互连被挤满。为了减轻壅塞,AWS在部分拥塞的私人网路互连上撤回BGP前缀,让流量改走另一组经由异地交换中心的私人网路互连,不过这条路径也很快达到极限。

事件之所以恶化,还受两项因素放大,其中一条直接对等链路因为早前的故障只能以半速运作,而连往异地交换中心的资料中心互连路径也尚未完成扩充。

对终端使用者而言,最明显的感受是延迟升高、请求逾时与传输速度下降。Cloudflare指出,事故期间边界路由器的高优先权伫列长时间出现封包丢弃,模拟用户连线至来源服务器的延迟指标(SLO)也同步恶化。虽然在壅塞解除后,封包丢弃率很快恢复正常,但由于AWS与Cloudflare同时调整前缀公告,延迟下降的速度相对较慢,部分终端使用者持续受到影响。

事故发生后,Cloudflare在Ashburn的监测系统侦测到壅塞,并与AWS展开协调。Cloudflare先针对流量暴增的单一用户採取限速措施,再透过流量工程调度逐步释放压力。AWS则同步恢复先前因分流而撤回的BGP前缀,双方合作下,受影响的连线逐步回复正常。

Cloudflare强调,这起事件凸显单一用户尖峰流量对整体互连的冲击。他们将建立自动化机制,让异常流量在影响其他用户前就能被降低优先顺序,并加速资料中心互连容量的扩充,同时和AWS调整路由策略,避免因双方动作重叠而加剧问题。