Stack Exchange启动了一项Answer Assistant实验,测试由人工智慧生成的回答是否能通过社群审核机制,成为公开的内容。然而,此举在社群内部引发广泛讨论与争议,部分用户担忧人工智慧内容可能影响平台的知识品质,甚至改变Stack Exchange作为人类策画知识库的核心价值。对于Stack Exchange来说,这项实验目的在于探索人工智慧技术,如何在维持人类维护的前提下,辅助使用者获得解答,但目前的实施方式已让不少资深贡献者感到不安,担忧这是否会削弱专家参与的动机。

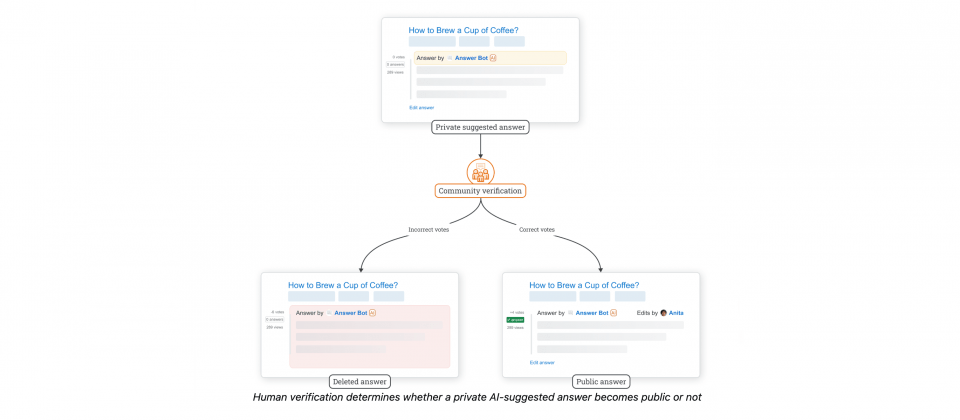

此次Answer Assistant实验会在部分站点先行测试,包括Arts & Crafts、Raspberry Pi和User Experience。当符合特定条件的问题在72小时内未获得讚赏或接受的回答时,系统将产生人工智慧建议的答案,但这些内容只有具有一定声望分数的使用者可以看见,并标注为人工智慧生成,待社群成员评估正确性。若多位使用者认定答案有效,该回答将公开显示,并由名为Answer Bot的帐号发表,若是人工智慧内容被判定为错误则会被删除,避免影响整体知识库品质。

这项机制的目标是减少未获解答的问题,并提供社群成员一个参考答案以进行编辑与补充。不过,部分社群成员对此持质疑态度,认为这与Stack Exchange长期以来强调的人类策画知识原则相违背。批评者认为,Stack Exchange一直以来的价值在于汇聚专家知识,让回答不只是正确,更是具有深度、完整性和可信度。而人工智慧生成的内容,即便经过人类审核,仍可能无法达到社群期望的水準,甚至增加专家审核的负担,让原本愿意贡献知识的使用者感到沮丧。

此外,另一个争议点在于审查机制是否足够严谨。目前官方设定的最低审查门槛为50声望分数,这远低于其他审查机制的标準,像是部分内容审核队列通常需要350、500甚至3,000以上的声望才能参与。一些社群成员质疑,低门槛可能导致机械式审查,让不具备足够专业知识的使用者轻易将人工智慧内容标记为正确,进而影响最终公开内容的品质。

还有一个引发社群不满的问题,是人工智慧内容的可追溯性与透明度。Stack Exchange官方表示人工智慧内容的来源目前无法提供明确的引用与出处,这与Stack Exchange一直以来强调的可验证资讯原则冲突。官方虽表示正在研究如何解决这个问题,但在没有明确解决方案的情况下,仍选择推动实验,让部分用户认为Stack Exchange在来源不可妥协的原则上存在双重标準。