图片来源:

图片来源: Opera

Opera宣布一项新功能,让用户可将大型语言模型(Large Language Model,LLM)下载到本机端执行或测试,不需再连上伺服器端。

大多数情况下,使用LLM必须将资料送到伺服器。本机端LLM则让用户可以直接在机器上处理提示,不须资料离开电脑。

在AI功能新增(Feature Drop)方案中,Opera实验支援将近50系列、共150款本机端LLM,允许用户透过自家浏览器下载。该公司表示这也是首个以内建功能支援并管理LLM的主要浏览器。

Opera支援本地端执行的模型,涵括Meta的Llama、Vicuna、Google的Gemma from Google及Mistral AI的Mixtral等。

新功能目前以测试版形式发布给Opera One开发人员。Opera One是这家浏览器业者去年6月推出的AI浏览器,整合原生AI技术的浏览器,目前整合该公司自己的AI助理Aria Chat。

今天起,开发人员可以下载Opera One开发人员版测试在本机上使用所支援的LLM及Opera实验性AI功能。Opera希望藉这波测试探索可能的应用场景,像是浏览器是否可根据用户和AI助理的对话纪录提供服务,又能保留用户装置上所有资料。

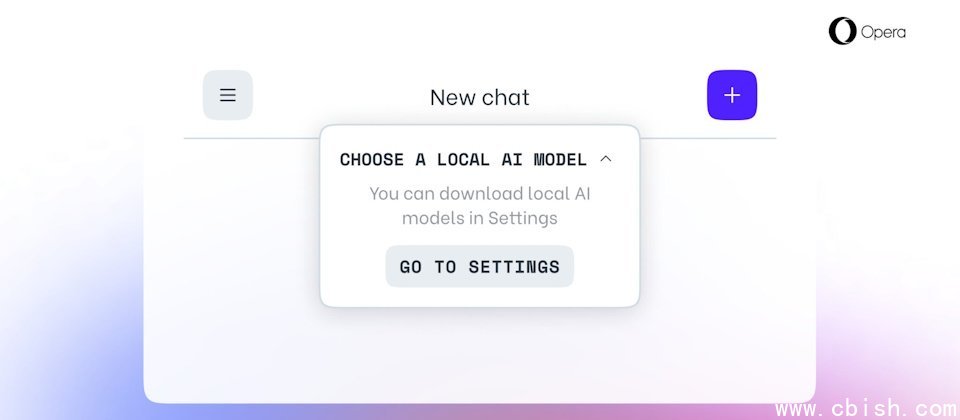

欲试用者,需先升级到最新版Opera。之后,由侧边工具栏上开启Aria Chat,在聊天介面上方点选「选择本机模式」的下拉式选单后,从「进入设定」选择欲下载的模型。完成下载后按左上方的选单,启动新对话。接着再次从「选择本机模式」中选择刚下载的模型,就能让AI助理套用新模型,用于应答。

Opera提醒,下载LLM需要本机有2GB到10GB的储存空间,而且视用户机器硬体规格而定,在本机上执行LLM的效能会比伺服器端版本来得慢很多。此外,本机端LLM不会使用Opera的Aria,直到用户以Aria启动新对话,或是直接换成Aria。Opera也提醒不要安装在营运用的机器上。